Was ist Robots.txt Tester?

Das Tool Robots.txt Tester von Sitechecker dient zur Validierung der robots.txt-Datei einer Website und stellt sicher, dass Suchmaschinen-Bots verstehen, welche Seiten indexiert oder ignoriert werden sollen. Dies erleichtert die effiziente Verwaltung der Sichtbarkeit einer Site in Suchergebnissen. Das Tool bietet umfassende Site-Checks zur Identifizierung von Indexierungsproblemen und bietet auch seitenspezifische Scans, um festzustellen, ob eine Seite indexiert ist. Dies verbessert die Genauigkeit der Suchmaschinenindexierung, indem Fehler in den Einstellungen der robots.txt-Datei schnell identifiziert und korrigiert werden.

Wie kann Ihnen das Tool helfen?

Validierung der robots.txt-Datei: überprüft die Richtigkeit der robots.txt-Datei einer Website und stellt sicher, dass sie Suchmaschinen-Bots korrekt leitet.

Seitenspezifische Scans: bietet die Möglichkeit zu prüfen, ob einzelne Seiten richtig indexiert sind oder nicht, was eine gezielte Fehlerbehebung ermöglicht.

Identifizierung von Indexierungsproblemen: bietet umfassende Prüfungen, um Indexierungsprobleme auf der gesamten Site zu erkennen.

Hauptfunktionen des Tools

Einheitliches Dashboard: bietet einen umfassenden Überblick über SEO-Metriken zur einfachen Überwachung.

Benutzerfreundliche Oberfläche: entwickelt für intuitive Navigation und einfache Bedienung.

Komplettes SEO-Toolset: bietet eine breite Palette von Tools zur Optimierung der Website-Leistung in Suchmaschinen.

So verwenden Sie das Tool

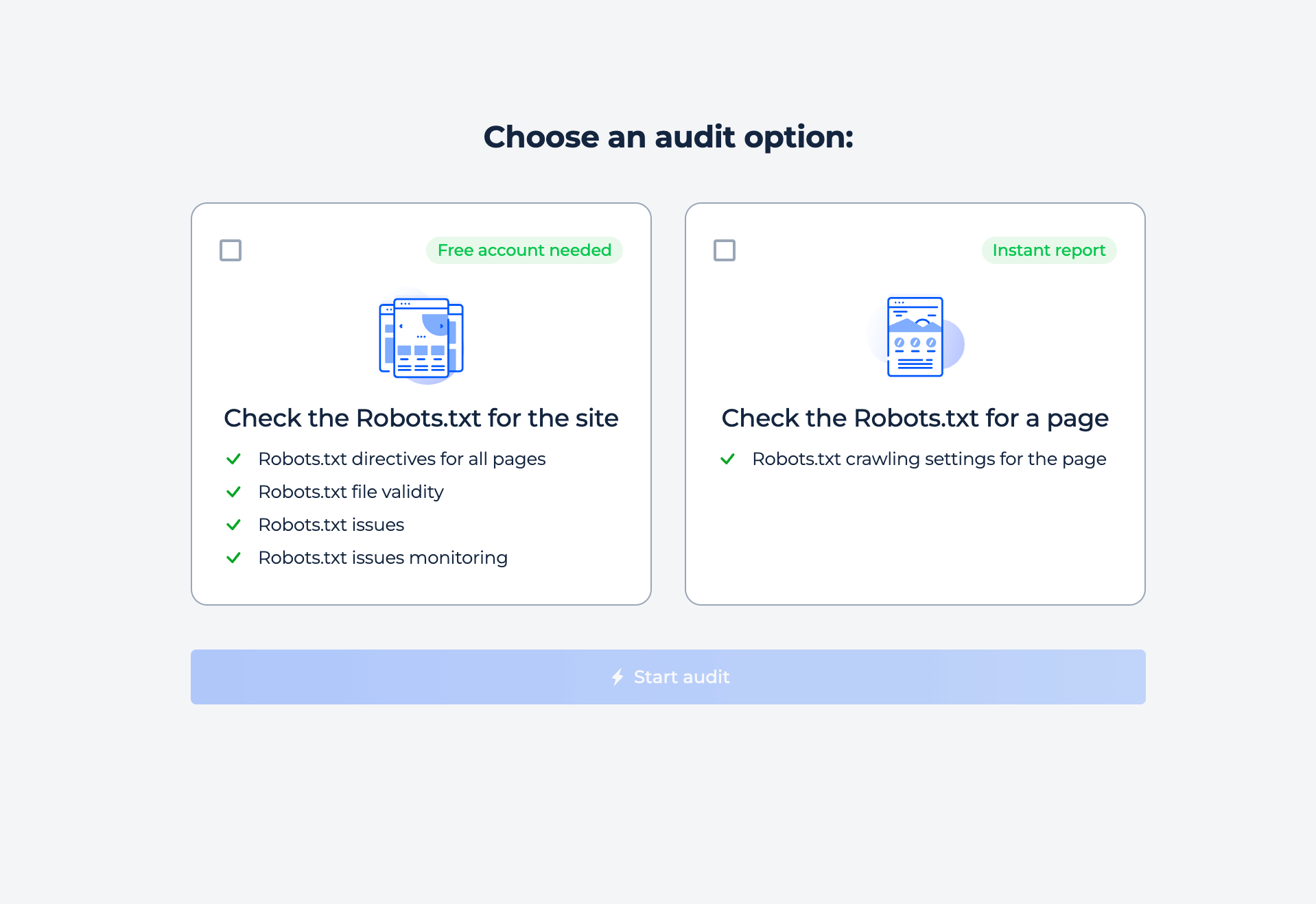

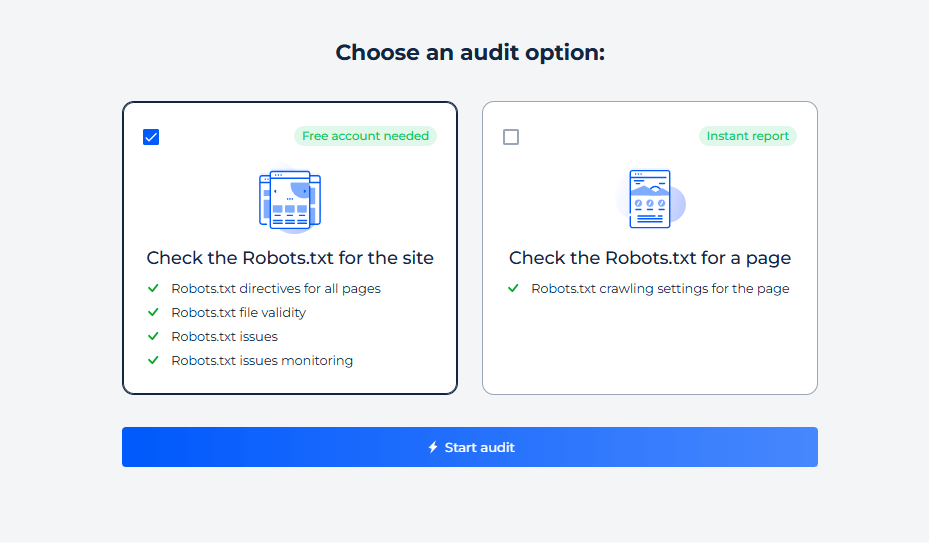

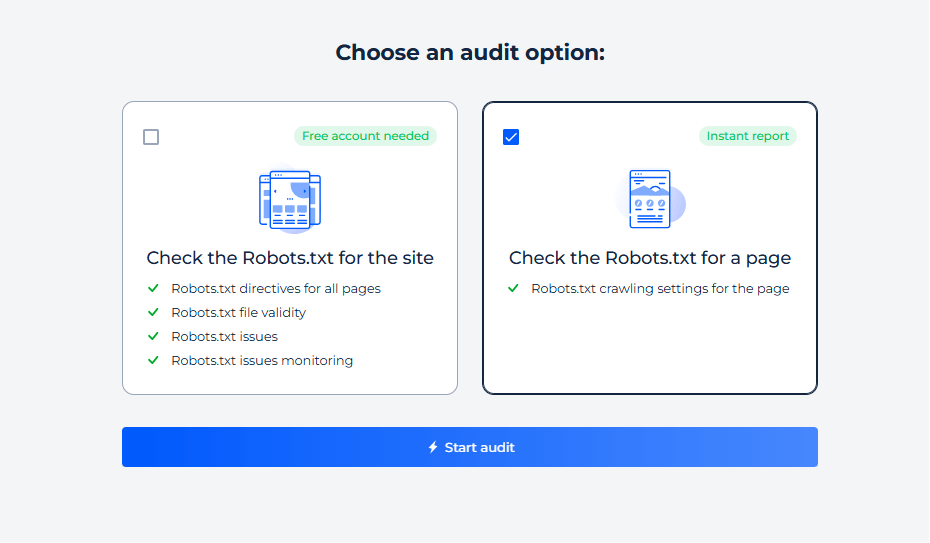

Das Tool bietet zwei Arten von Online-Scans: ganze Site und einzelne Seite. Wählen Sie einfach die gewünschte Option aus und starten Sie den Scan.

Test der Site Robots.txt-Datei

Um die Robot-Einstellungen Ihrer Site zu überprüfen und Indexierungsprobleme aufzudecken, wählen Sie einfach die Site-Inspektionsoption. Innerhalb weniger Minuten erhalten Sie einen umfassenden Bericht.

Schritt 1: Wählen Sie die Site-Prüfung

Schritt 2: Ergebnisse abrufen

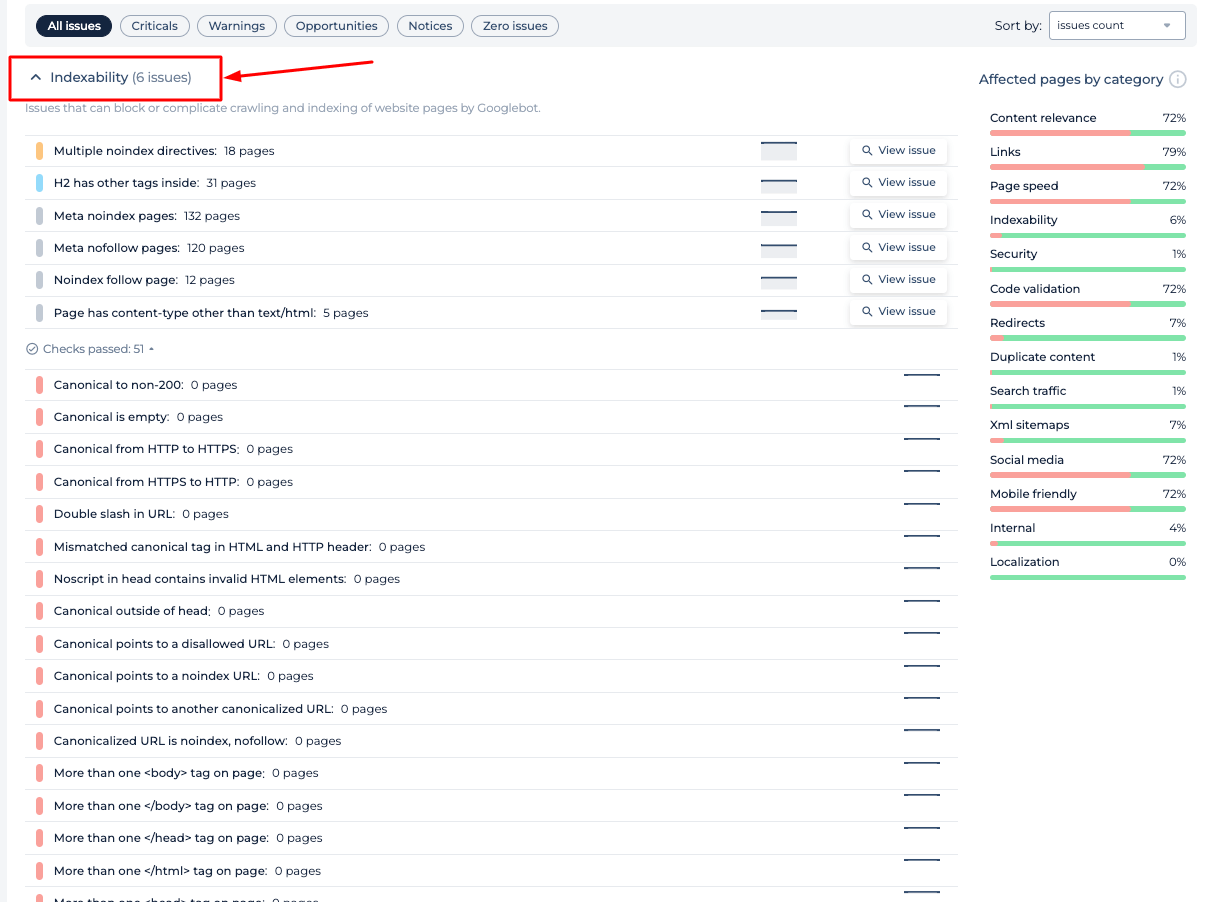

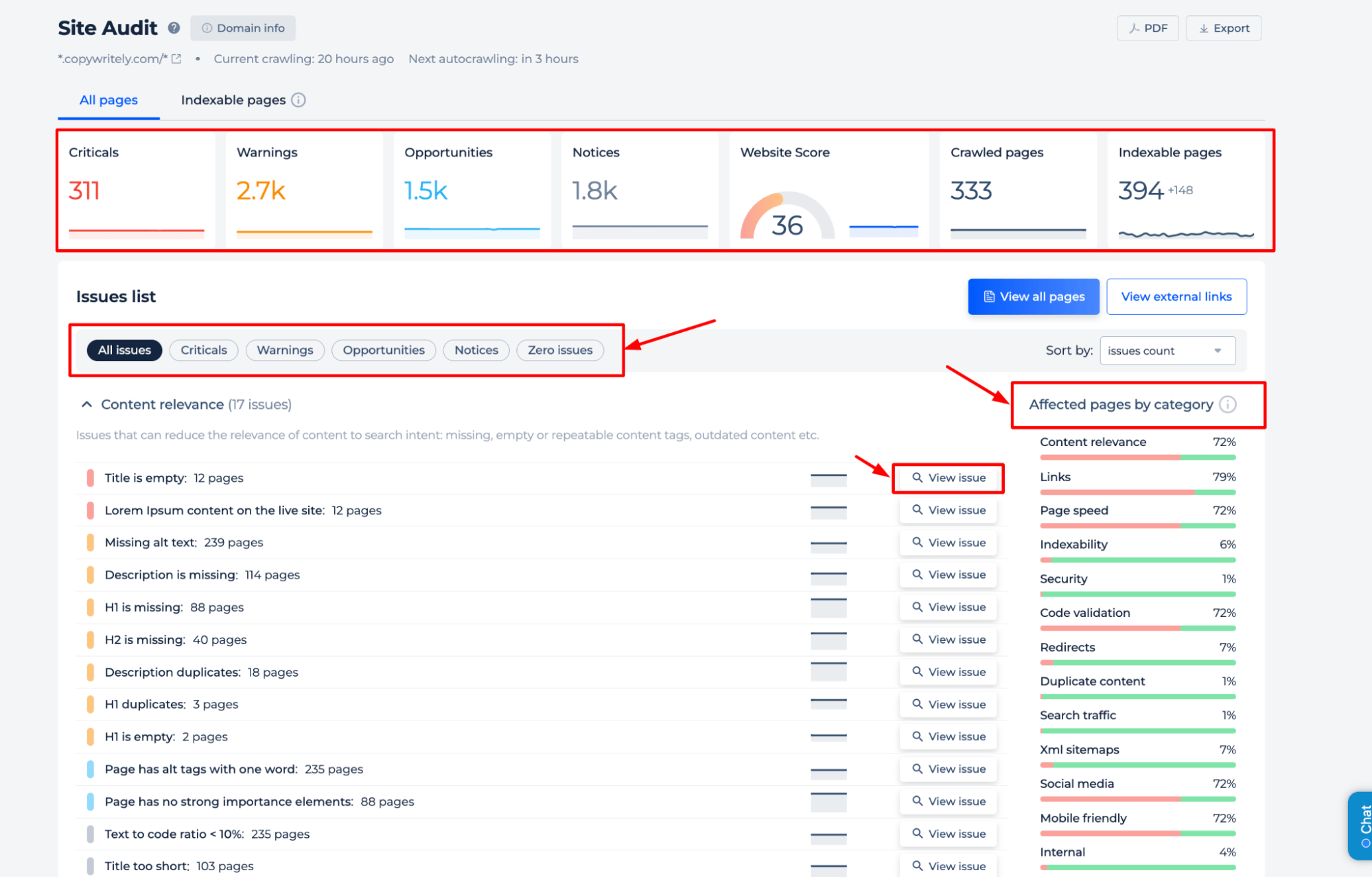

Der Robots.txt Analyzer zur Bewertung der Konfiguration von Serverdirektivendateien liefert Ihnen wertvolle Daten darüber, wie die Direktiven Ihrer Website die Indizierung durch Suchmaschinen beeinflussen. Der Bericht enthält die Identifizierung von Seiten, deren Crawling blockiert ist, spezifische Direktiven wie „noindex“ und „nofollow“ sowie alle für Suchmaschinen-Bots festgelegten Crawl-Verzögerungen. Dies trägt dazu bei, sicherzustellen, dass die Crawl-Richtliniendatei der Website eine optimale Sichtbarkeit der Website und Zugänglichkeit für Suchmaschinen ermöglicht.

Zusätzliche Funktionen

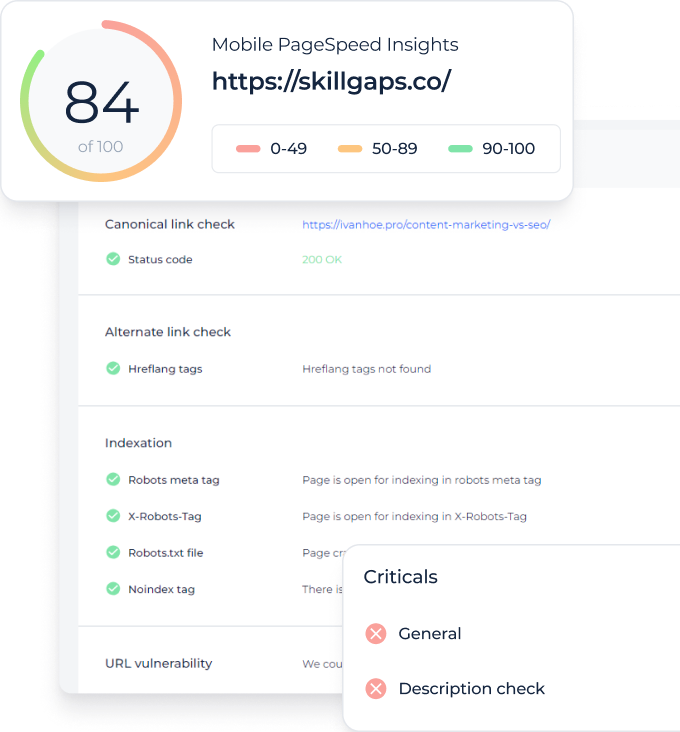

Der Robots.txt Checker bietet eine umfassende Analyse der SEO-Gesundheit einer Website. Er identifiziert kritische Probleme, Warnungen, Verbesserungsmöglichkeiten und allgemeine Hinweise. Detaillierte Einblicke werden in die Inhaltsrelevanz, Linkintegrität, Seitengeschwindigkeit und Indexierbarkeit gegeben. Die Prüfung kategorisiert betroffene Seiten, sodass Benutzer Optimierungen für eine bessere Sichtbarkeit in Suchmaschinen priorisieren können. Diese Funktion ergänzt den Robots.txt-Checker, indem sie sicherstellt, dass auch umfassendere SEO-Elemente berücksichtigt werden.

Robots.txt für eine bestimmte Seite testen

Schritt 1: Eine Prüfung für eine bestimmte Seite starten

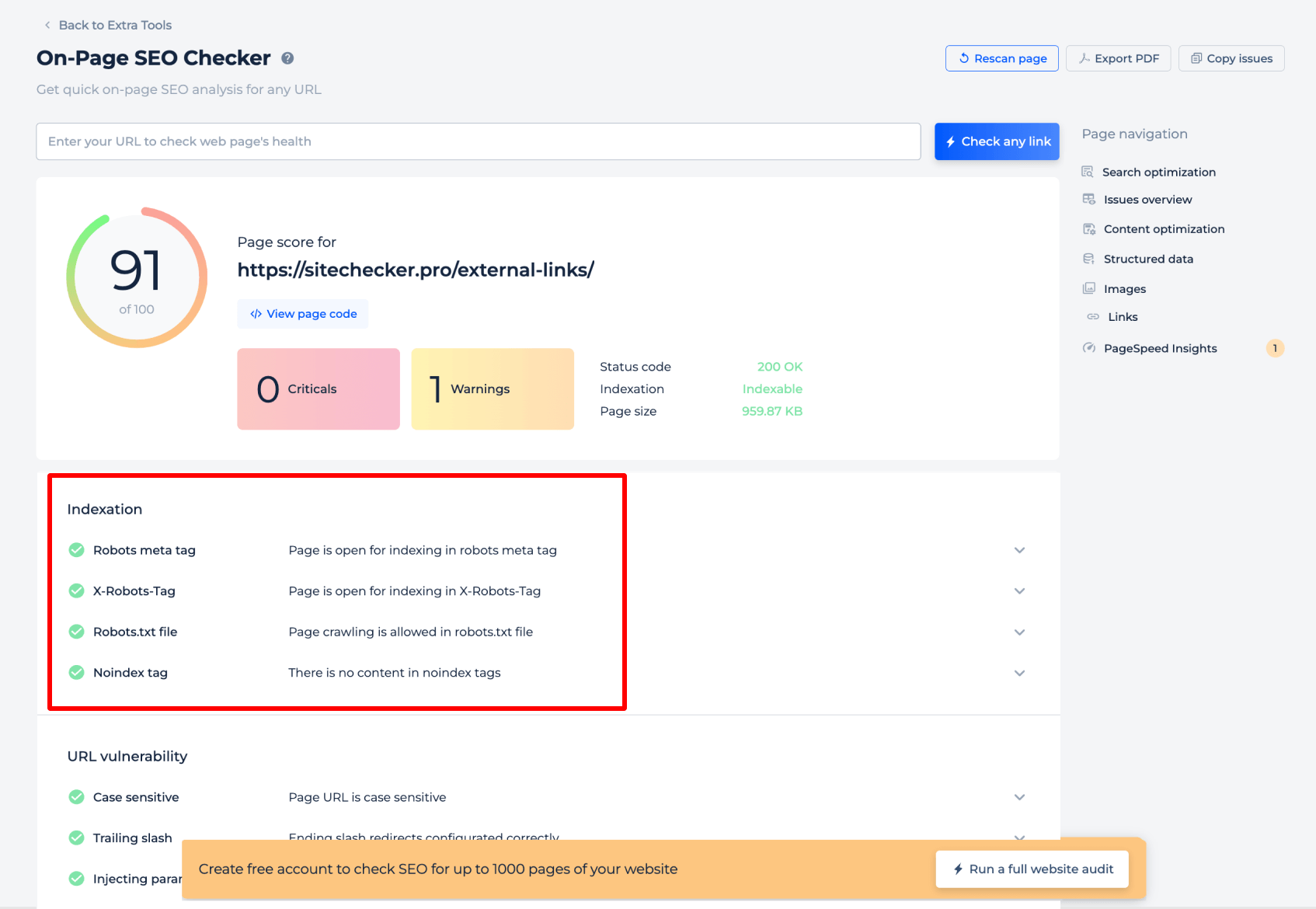

Schritt 2: Die Ergebnisse abrufen

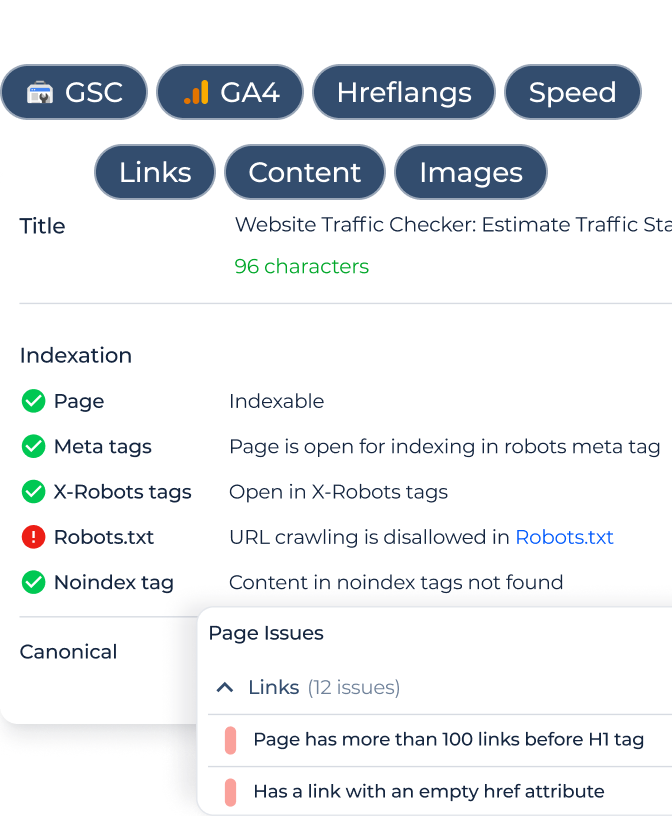

Der Robots.txt-Tester für eine bestimmte Seite liefert wichtige Einblicke in die Art und Weise, wie Suchmaschinen Robots.txt-Anweisungen für diese Seite interpretieren. Er analysiert das Robots-Meta-Tag und das X-Robots-Tag, um zu bestätigen, ob die Seite für die Indizierung geöffnet ist. Darüber hinaus wird überprüft, ob das Crawling durch die Crawling-Richtliniendatei der Website zulässig ist, und es wird nach dem Vorhandensein von „Noindex“-Tags gesucht, die die Indizierung verhindern könnten. Diese gezielte Bewertung stellt sicher, dass jede Seite richtig konfiguriert ist, um für Suchmaschinen-Bots zugänglich zu sein.

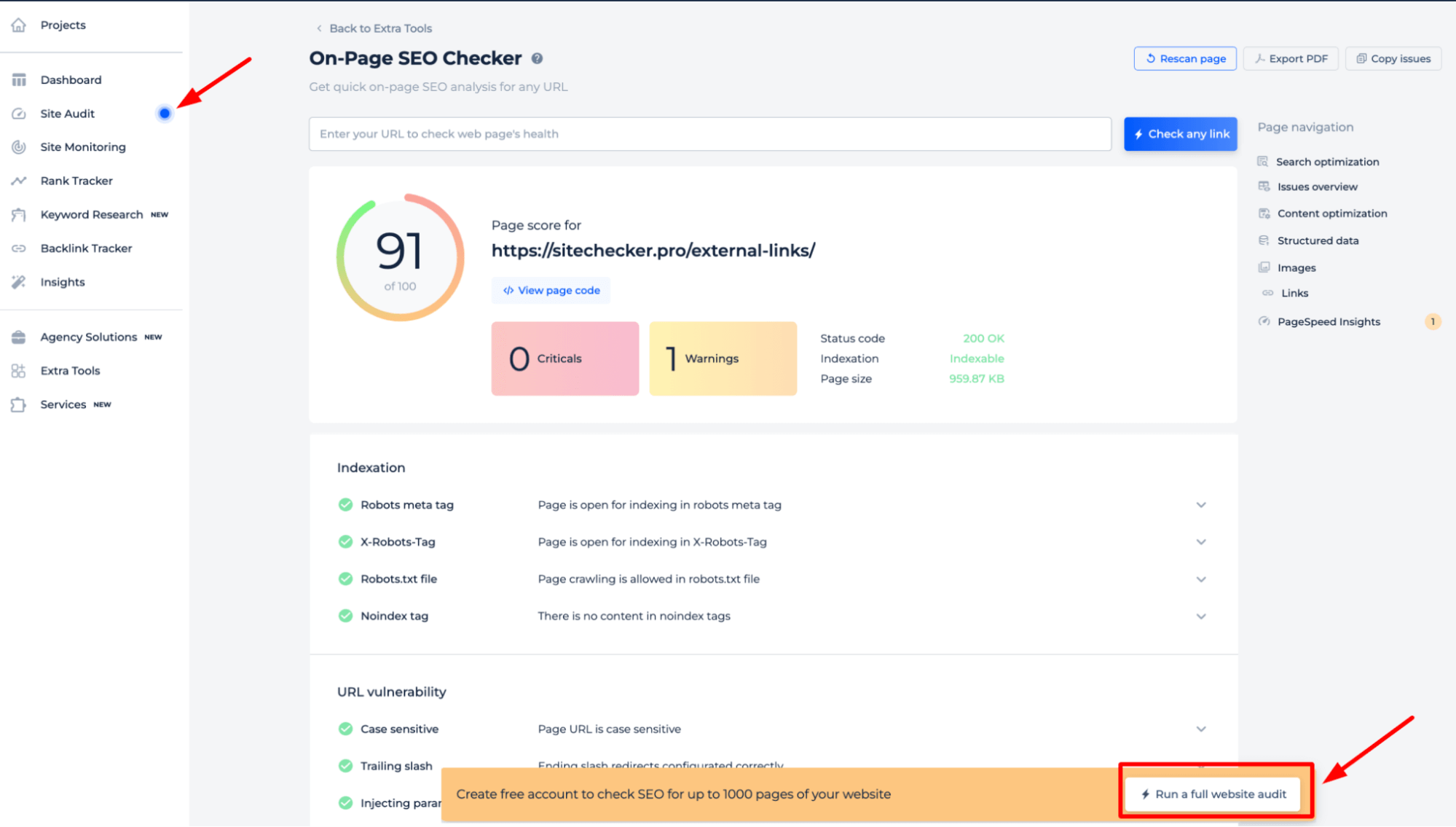

Um ein umfassendes Verständnis der robots.txt-Anweisungen Ihrer Site zu erlangen, sollten Sie am besten eine vollständige Website-Prüfung durchführen. Dadurch werden alle Indexierungsprobleme auf Ihrer gesamten Site aufgedeckt. Um die Prüfung zu starten, klicken Sie einfach auf das Banner „Vollständige Website-Prüfung starten“. Über den Abschnitt „Site-Prüfung“ ist eine Demoversion des Tools zugänglich, mit der Sie seine Funktionen testen können.

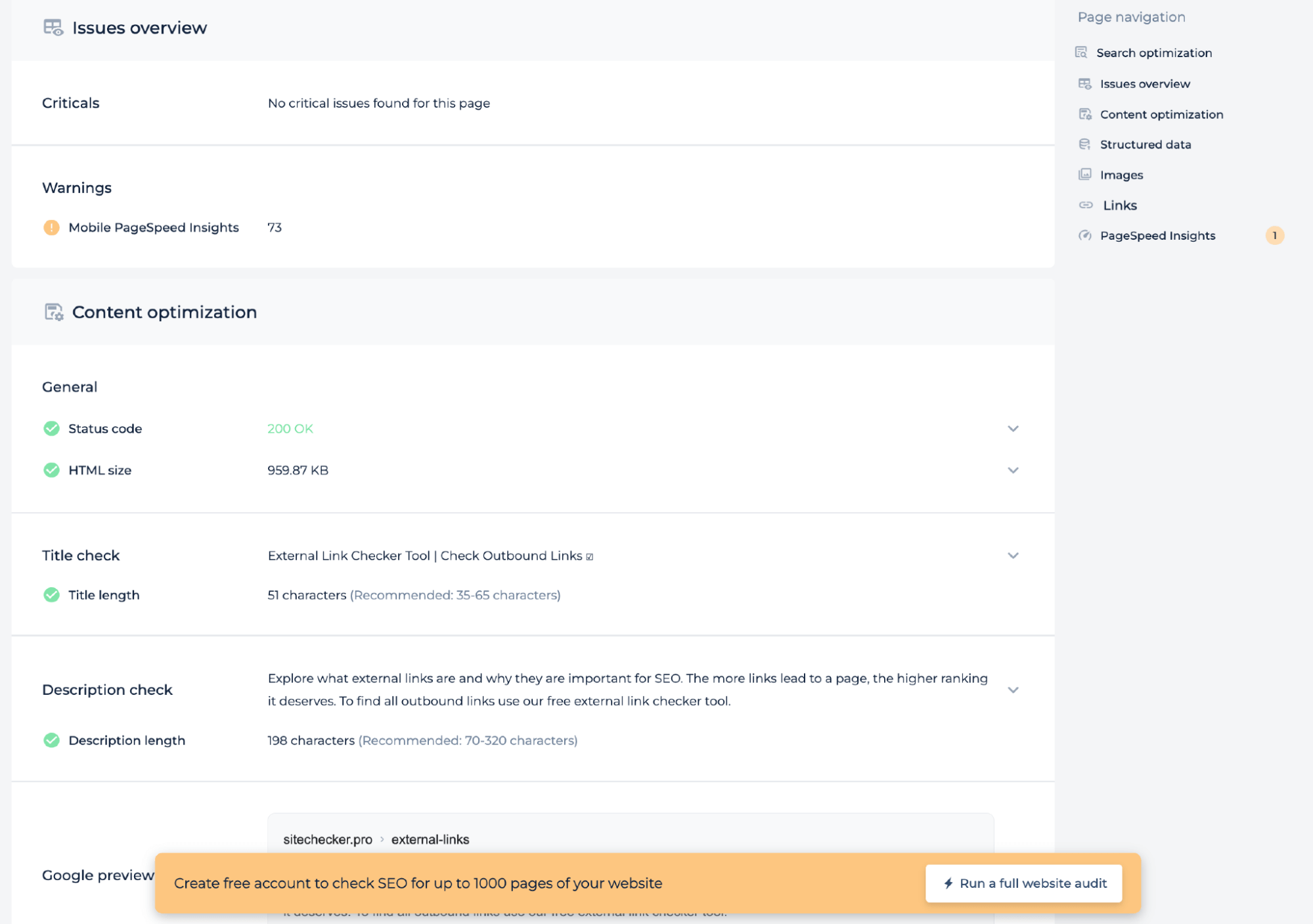

Zusätzliche Funktionen

Zusätzlich zum Testen der Server-Anweisungsdatei für eine bestimmte Seite bietet die technische Prüfung Einblicke in die Seitenintegrität wie den mobilen PageSpeed-Score, den Statuscode und die HTML-Größe. Es prüft, ob die Längen von Titel und Beschreibung den empfohlenen Standards entsprechen, und bietet eine Google-Vorschau, um sicherzustellen, dass die Seite für Suchmaschinen optimiert ist. Diese Analyse hilft dabei, die technische SEO der Seite zu verbessern.

Abschließende Idee

Der Robots.txt Tester ist ein robustes SEO-Diagnosetool, das sicherstellt, dass die Serverdirektivendatei einer Website Suchmaschinen-Bots richtig leitet. Es bietet sowohl vollständige Site- als auch seitenspezifische Scans und deckt alle Indexierungsbarrieren auf. Benutzer profitieren von einer benutzerfreundlichen Oberfläche, einer umfangreichen Suite von SEO-Tools und einem einheitlichen Dashboard zur Überwachung. Die umfassenden Prüffunktionen des Tools ermöglichen die Identifizierung einer Vielzahl technischer SEO-Probleme, einschließlich Inhaltsoptimierung und Seitenintegritätsmetriken, und stellen sicher, dass jede Seite für die Entdeckung und das Ranking durch Suchmaschinen gerüstet ist.