Um arquivo robots.txt é um arquivo de texto colocado em sites para informar aos robôs dos mecanismos de pesquisa (como o Google) quais páginas desse domínio podem ser rastreadas . Se o seu site tiver um arquivo robots.txt, você poderá realizar a verificação com nossa ferramenta geradora de Robots.txt gratuita . Você pode integrar um link para um mapa do site XML no arquivo robots.txt.

Antes de bots de mecanismos de pesquisa rastrearem seu site, eles primeiro localizarão o arquivo robots.txt do site. Assim, eles verão instruções sobre quais páginas do site podem ser indexadas e quais não devem ser indexadas pelo console do mecanismo de busca.

Com este arquivo simples, você pode definir as opções de rastreamento e indexação para bots de mecanismos de pesquisa. E para verificar se o arquivo Robots.txt está configurado em seu site, você pode usar nossas ferramentas gratuitas e simples do Testador Robots.txt. Este artigo explicará como validar um arquivo com a ferramenta e por que é importante usar o Robots.txt Tester em seu site.

Uso da ferramenta de verificação Robots.txt: um guia passo a passo

O teste Robots.txt ajudará você a testar um arquivo robots.txt em seu domínio ou em qualquer outro domínio que você queira analisar.

A ferramenta verificador robots.txt detectará rapidamente erros nas configurações do arquivo robots.txt. Nossa ferramenta validadora é muito fácil de usar e pode ajudar até mesmo um profissional ou webmaster inexperiente a verificar um arquivo Robots.txt em seu site. Você obterá os resultados em alguns instantes.

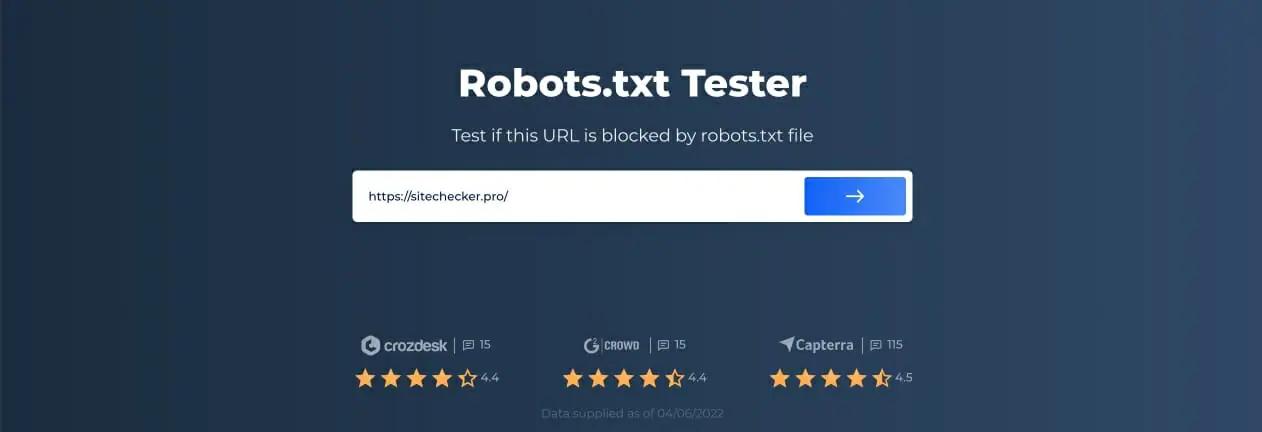

Etapa 1: insira seu URL

Para iniciar a digitalização, tudo o que você precisa fazer é inserir o URL de interesse na linha em branco e clicar no botão de seta azul. A ferramenta então começará a escanear e gerar resultados. Você não precisa se registrar em nosso site para usá-lo.

Como exemplo, decidimos analisar nosso site https://sitechecker.pro. Nas capturas de tela abaixo, você pode ver o processo de digitalização em nossa ferramenta de site.

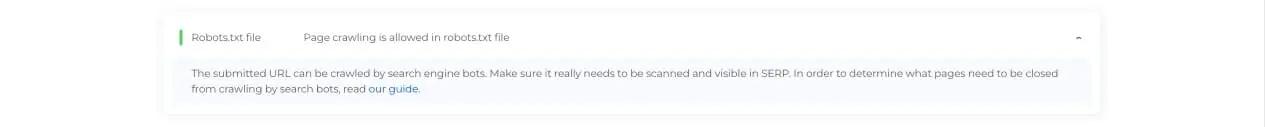

Etapa 2: interpretando os resultados do testador Robots.txt

Em seguida, quando a verificação terminar, você verá se o arquivo Robots.txt permite o rastreamento e a indexação de uma determinada página disponível. Assim, você pode verificar se sua página da web receberá tráfego do mecanismo de pesquisa. Aqui você também pode obter alguns conselhos de monitoramento úteis.

Casos em que o verificador Robots.txt é necessário

Problemas com o arquivo robots.txt, ou a falta dele, podem afetar negativamente suas classificações nos mecanismos de pesquisa. Você pode perder pontos de classificação nas SERPs. Analisar este arquivo e seu significado antes de rastrear seu site significa que você pode evitar problemas com o rastreamento. Além disso, você pode evitar adicionar o conteúdo do seu site às páginas de exclusão de índice que não deseja que sejam rastreadas. Use este arquivo para restringir o acesso a determinadas páginas do seu site. Se houver um arquivo vazio, você poderá obter um Problema não encontrado do Robots.txt em SEO-rastreador.

Você pode criar um arquivo com um editor de texto simples. Primeiro, especifique o agente personalizado para executar a instrução e coloque a diretiva de bloqueio como disallow, noindex. Depois disso, liste os URLs que você está restringindo o rastreamento. Antes de executar o arquivo, verifique se está correto. Mesmo um erro de digitação pode fazer com que o Googlebot ignore suas instruções de validação.

Quais ferramentas de verificação do robots.txt podem ajudar

Ao gerar o arquivo robots.txt, você precisa verificar se ele contém algum erro. Existem algumas ferramentas que podem ajudá-lo a lidar com essa tarefa.

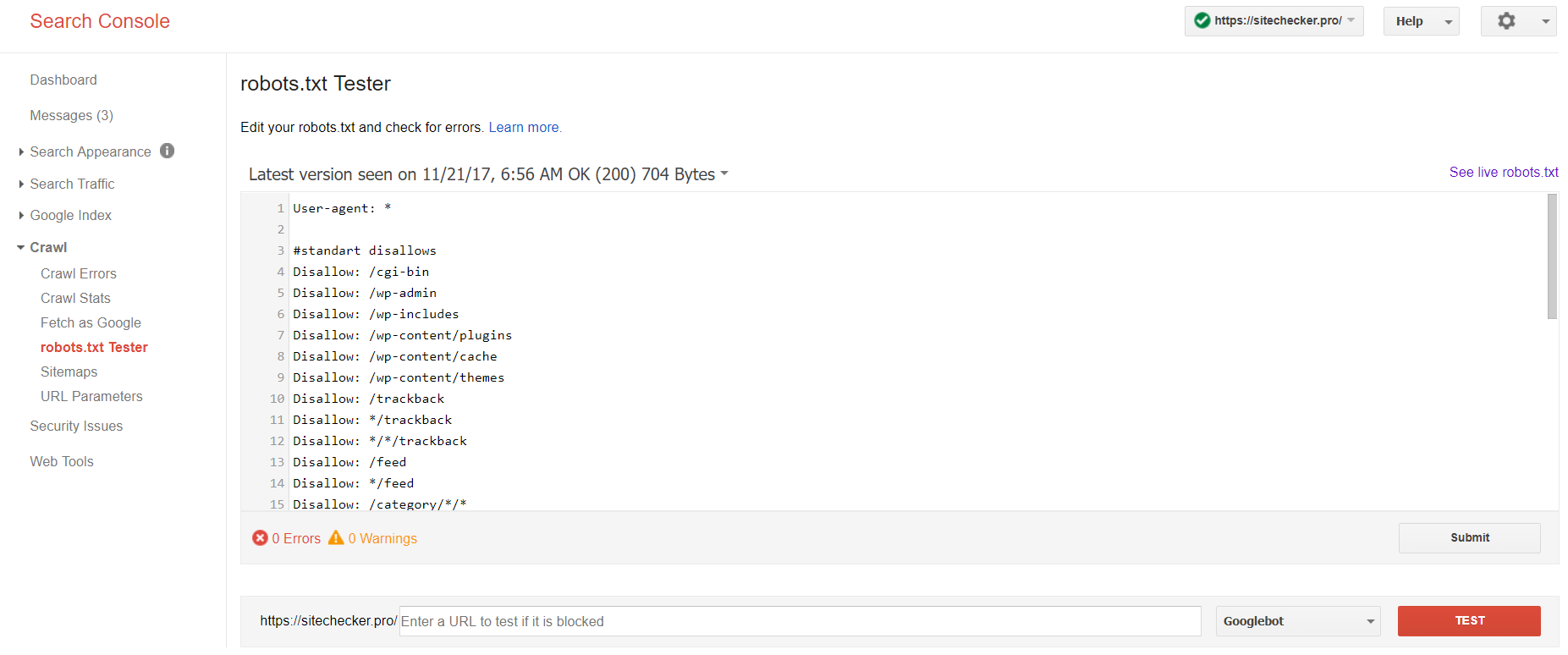

Google Search Console

Agora apenas a versão antiga do Google Search Console tem ferramenta para testar o arquivo robots. Faça login na conta com o site atual confirmado em sua plataforma e use este caminho para encontrar o validador.

Versão antiga do Google Search Console > Rastrear > Testador Robots.txt

Este teste robot.txt permite que você:

- detecte todos os seus erros e possíveis problemas de uma só vez;

- verifique se há erros e faça as correções necessárias aqui mesmo para instalar o novo arquivo em seu site sem nenhuma verificação adicional;

- examine se você fechou adequadamente as páginas que gostaria de evitar o rastreamento e se aquelas que deveriam passar por indexação foram abertas adequadamente.

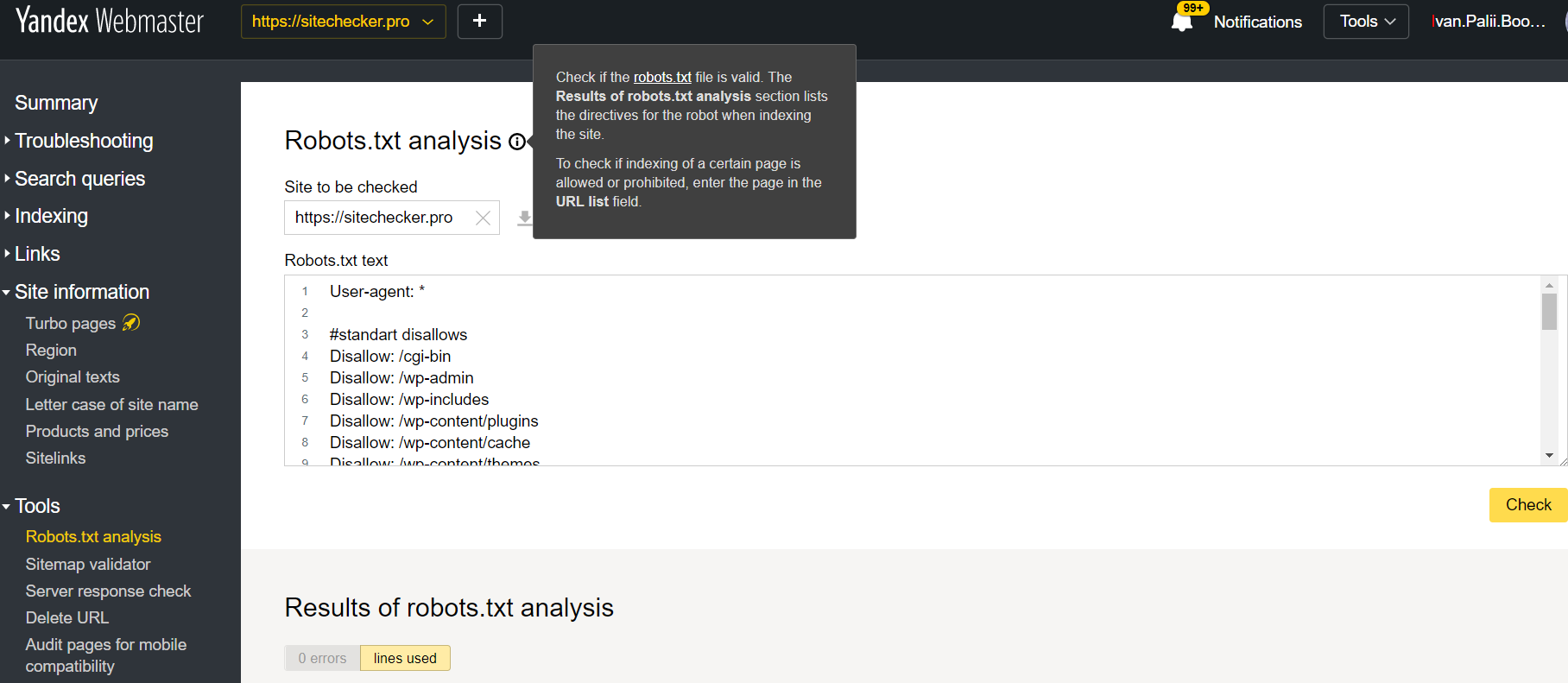

Webmaster Yandex

Faça login na conta Yandex Webmaster com a confirmação do site atual confirmado em sua plataforma e use este caminho para encontrar a ferramenta.

Webmaster Yandex > Ferramentas > Análise de robots.txt

Este testador oferece oportunidades de verificação quase iguais às descritas acima. A diferença reside em:

- aqui você não precisa autorizar e provar os direitos de um site que oferece uma verificação imediata do seu arquivo robots.txt;

- não há necessidade de inserir por página: toda a lista de páginas pode ser verificada em uma sessão;

- você pode ter certeza de que o Yandex identificou corretamente suas instruções.

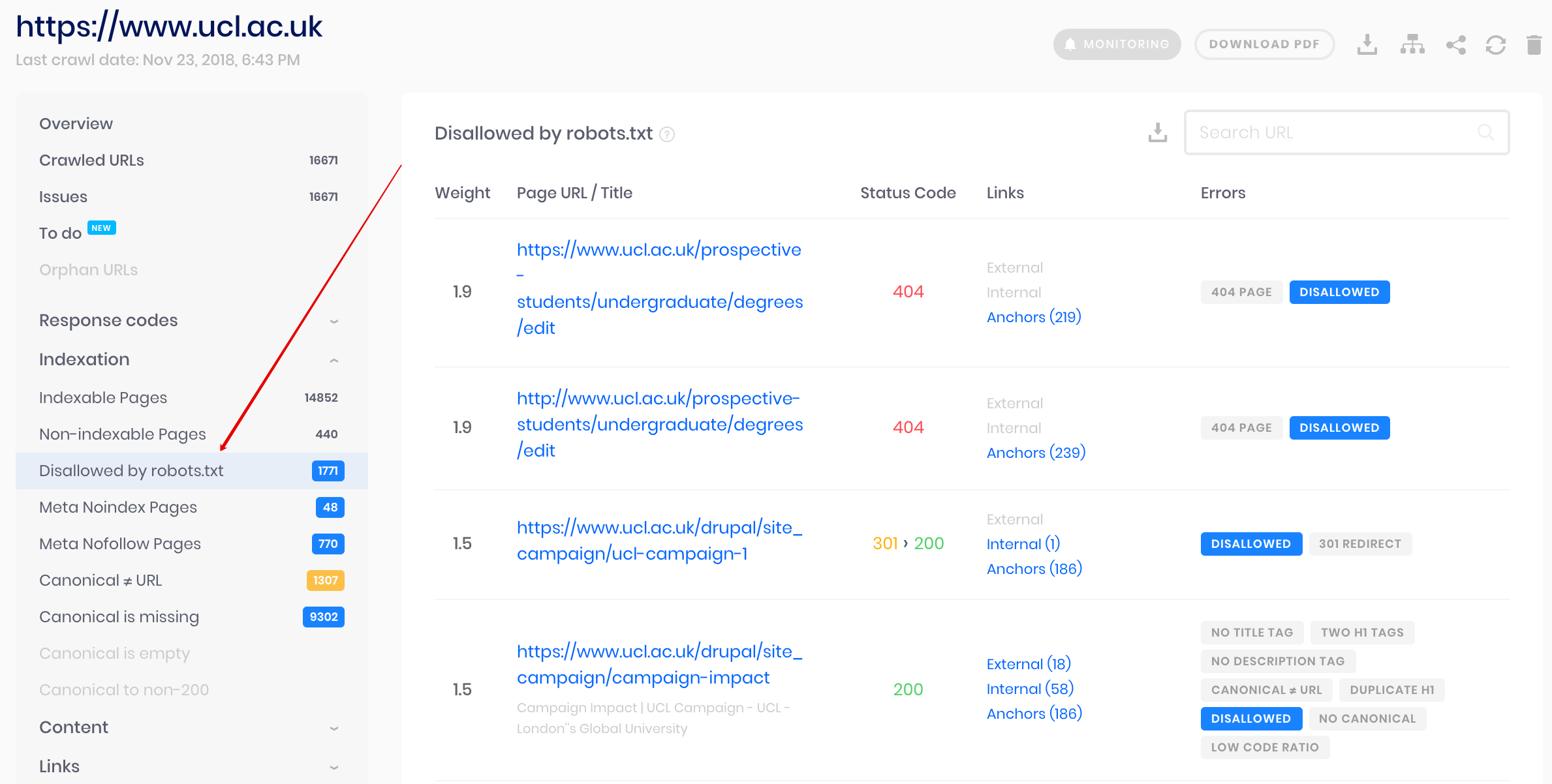

Rastreador do Verificador de site

Esta é uma solução para verificação em massa se você precisar rastrear site. Nosso rastreador ajuda a auditar todo o site e detectar quais URLs não são permitidos no robots.txt e quais são fechados da indexação por meio da metatag noindex.

Atenção: para detectar páginas não permitidas, você deve rastrear o site com a configuração “ignorar robots.txt”.

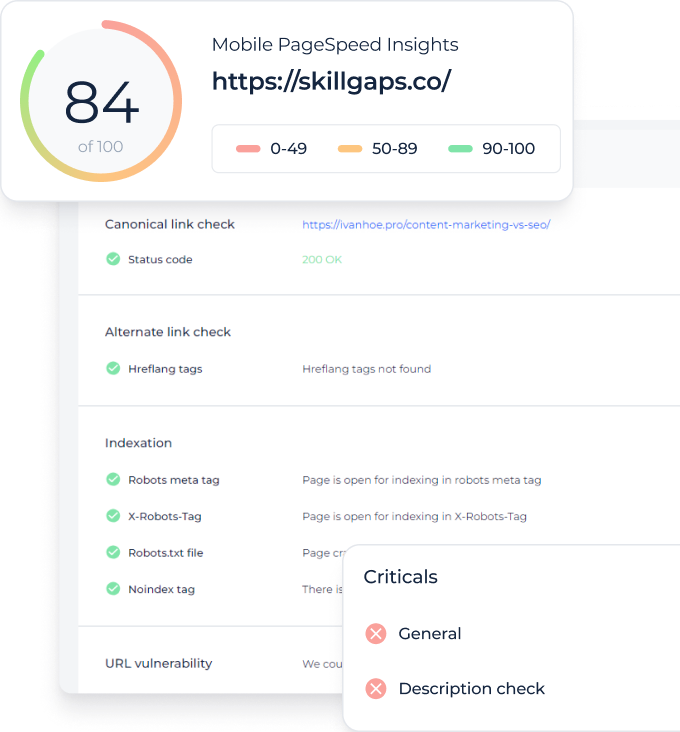

Detectar e analisar não apenas o arquivo robots.txt, mas também outro tipo de problema de SEO em seu site!

Faça uma auditoria completa para descobrir e corrigir os problemas do seu site para melhorar seus resultados de SERP.

Por que preciso verificar meu arquivo Robots.txt?

Robots.txt mostra aos mecanismos de pesquisa quais URLs em seu site eles podem rastrear e indexar, principalmente para evitar sobrecarregar seu site com consultas. Verificar este arquivo válido é recomendado para certificar-se de que ele funciona corretamente.