O que é um verificador de mapa do site?

O XML Sitemap Finder é uma ferramenta para verificar se um site tem um mapa XML.

Pode utilizar o Google Sitemap Checker para verificar se o seu Web site tem um Mapa do Web site XML e para identificar quaisquer erros. Se a ferramenta encontrar algum erro, dir-lhe-á como corrigi-lo.

O XML Sitemap Checker pode ajudá-lo em várias áreas importantes:

- Verifica a presença de um ficheiro XML no seu site.

- Ele detecta quaisquer problemas dentro do arquivo xml do mapa do seu site.

- Aumenta a eficiência com que os motores de busca indexam o seu site.

Principais Características do Sitemap Tester

Dashboard unificado. Um painel unificado fornece uma visão única dos dados técnicos de SEO, facilitando o rastreamento e o gerenciamento de seu desempenho.

Interface amigável. A interface amigável facilita o uso do Sitechecker, mesmo que você não seja um especialista técnico.

Conjunto completo de ferramentas de SEO. A Sitemap Lookup Tool é parte de um conjunto completo de ferramentas de SEO que pode ajudá-lo a melhorar a classificação do seu site nas páginas de resultados dos motores de busca (SERPs).

Como usar o XML Sitemap Finder

Felizmente, não há necessidade de verificar manualmente o código do seu site para perceber se tem o ficheiro que lista as páginas essenciais de um site. Com a ajuda do Sitemap Detetor, é possível consultar qualquer site para obter essas informações.

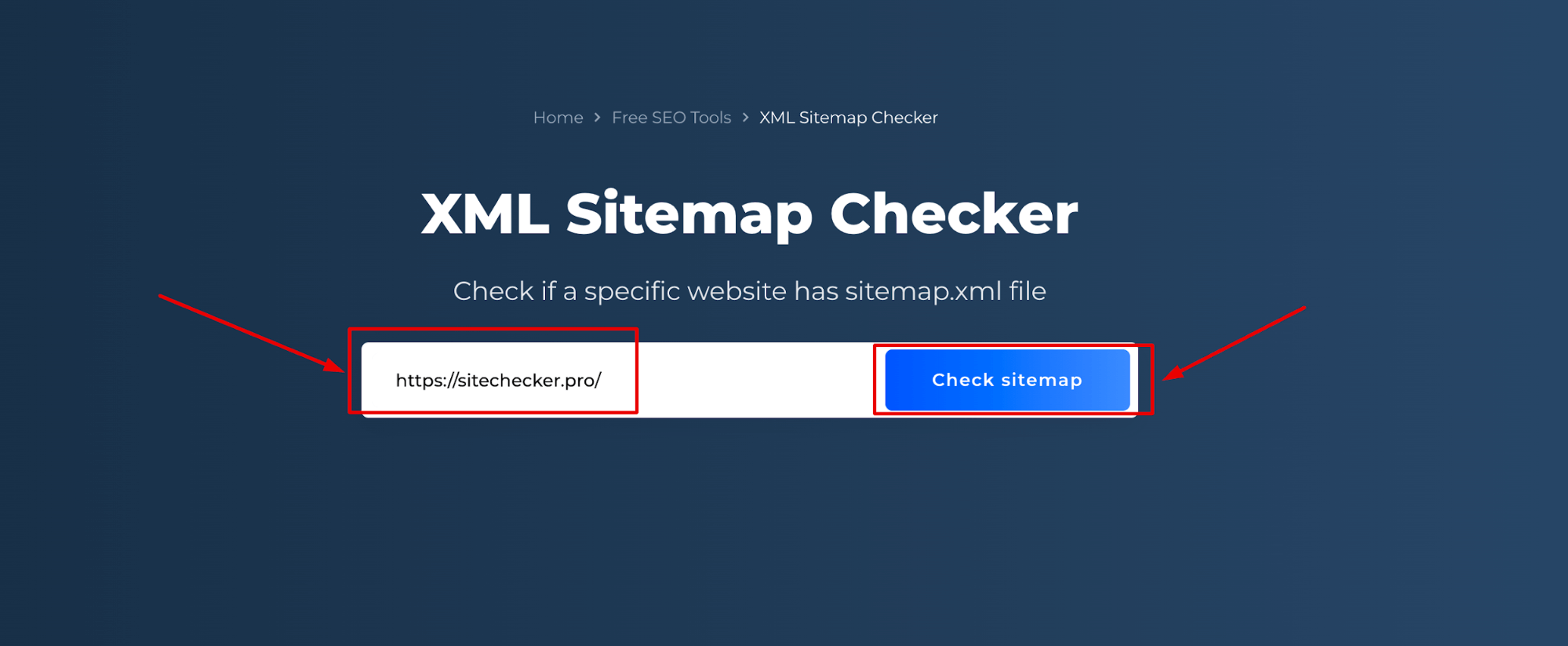

Passo 1: Insira o seu nome de domínio

O primeiro passo é introduzir o URL do seu sítio Web:

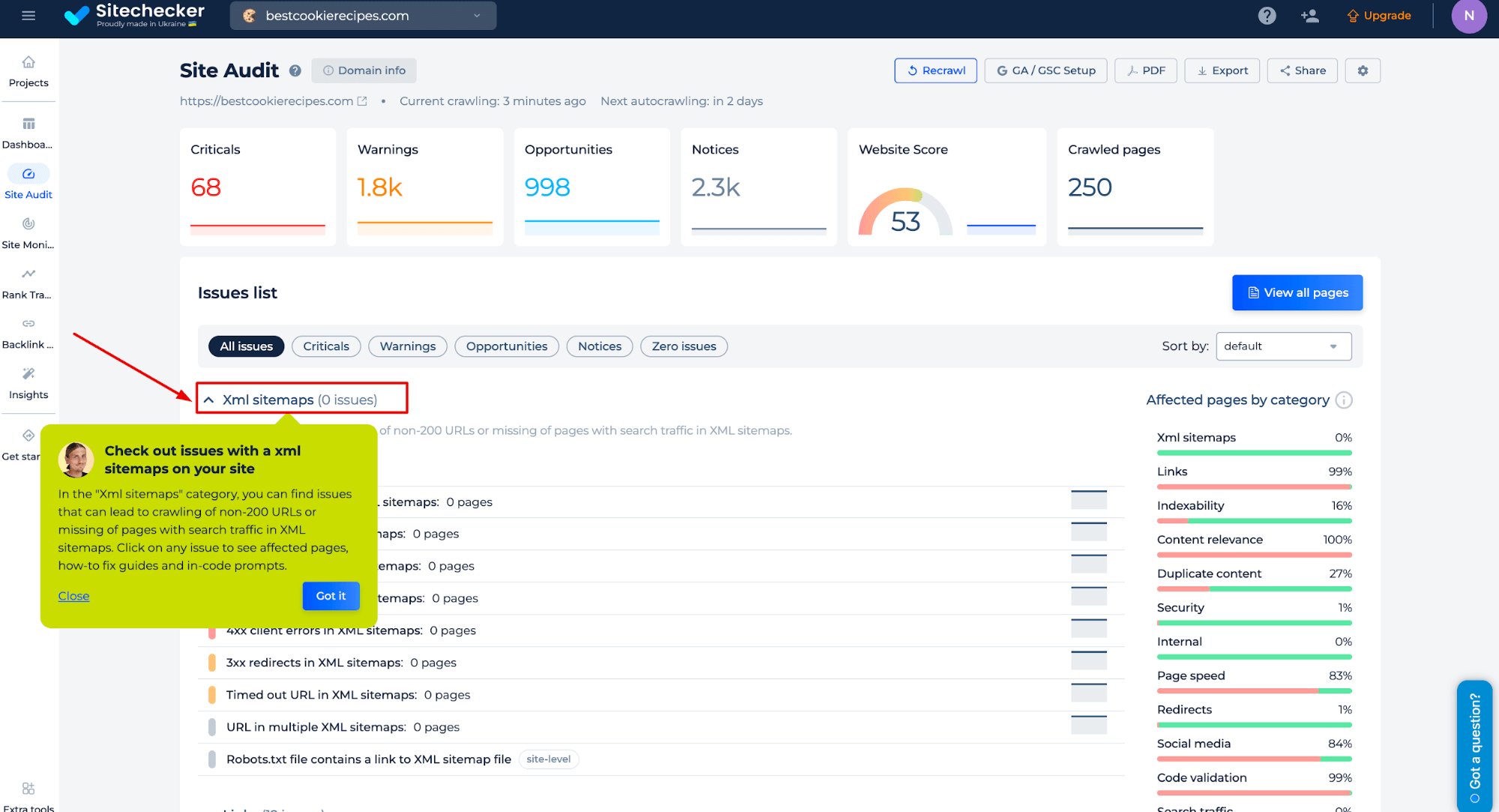

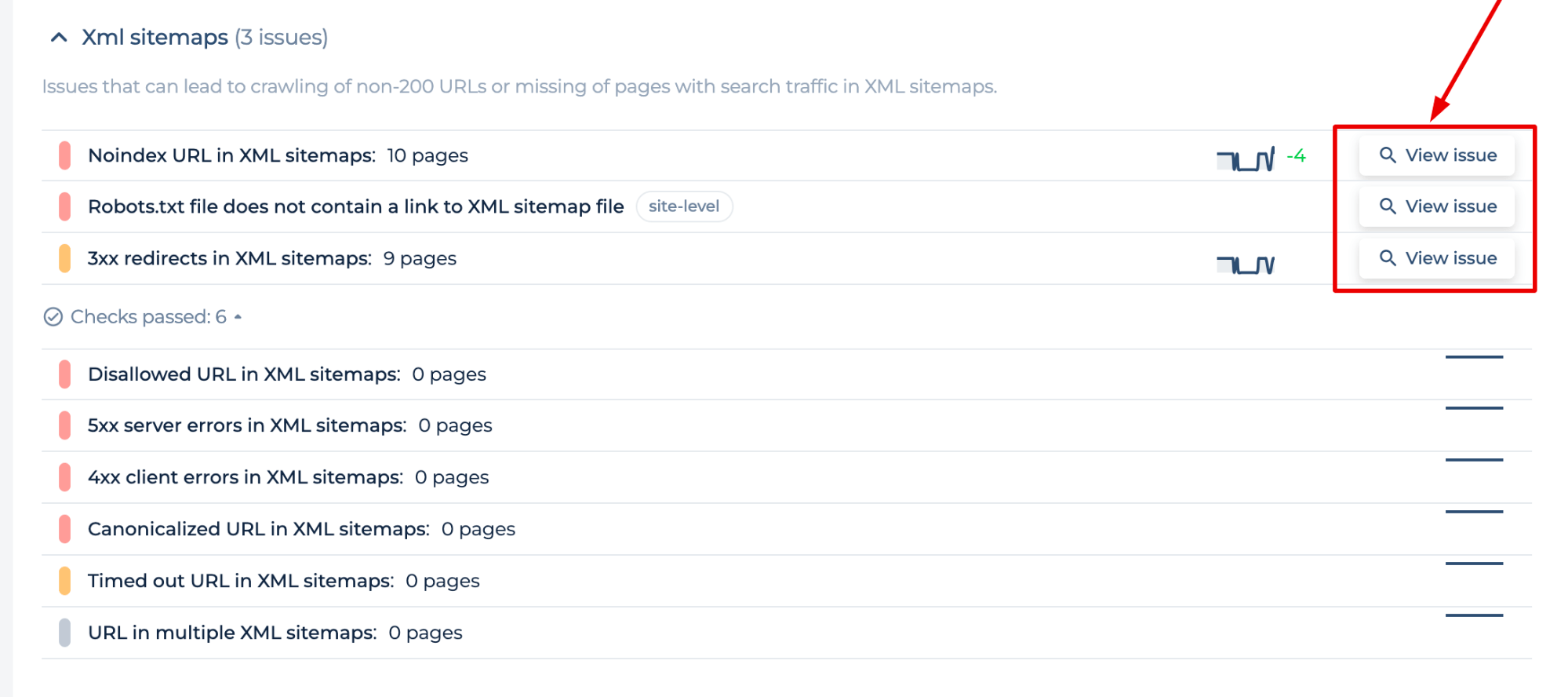

Passo 2: Interpretando os resultados do Sitemap Tester

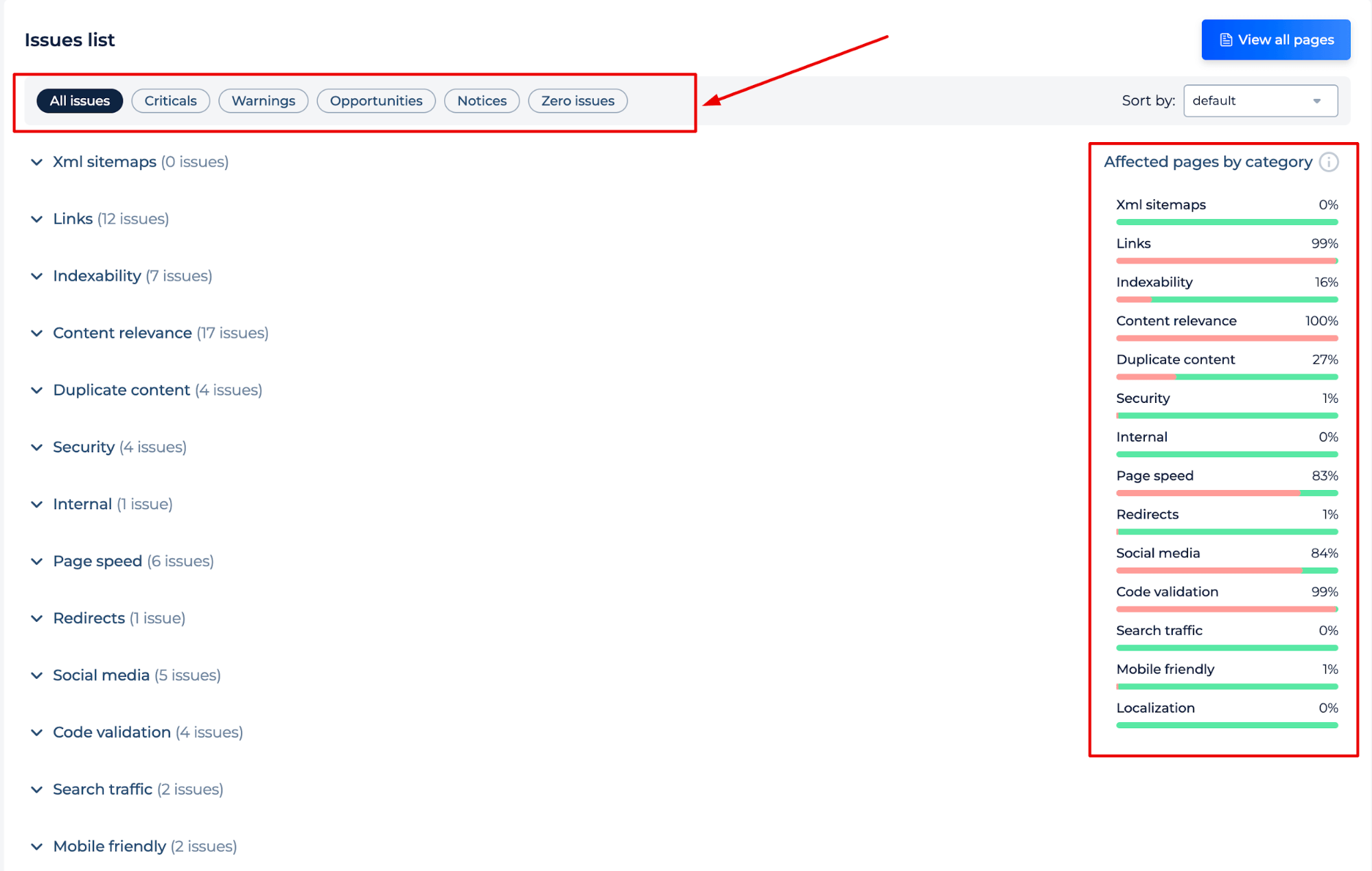

A análise efectuada gera uma auditoria do site para o domínio introduzido. Na categoria “XML sitemaps”, pode encontrar problemas que podem levar ao rastreio de URLs não-200 ou páginas em falta com tráfego de pesquisa em mapas XML. Clique em qualquer problema para ver as páginas afectadas, os guias de correção e os avisos no código.

O testador de mapas do site permite-lhe identificar erros de mapas do site e obter instruções sobre como resolvê-los para reduzir o efeito dos erros de mapas do site na sua indexação:

- Non 2xx status code URL in sitemap (3xx redirects, 5xx server errors, 4xx errors)

- Noindex URL e Disallowed URL

- Arquivo Robots.txt sem link para sitemap XML, URL em múltiplos XML, Arquivo Sitemap.xml muito grande, etc.

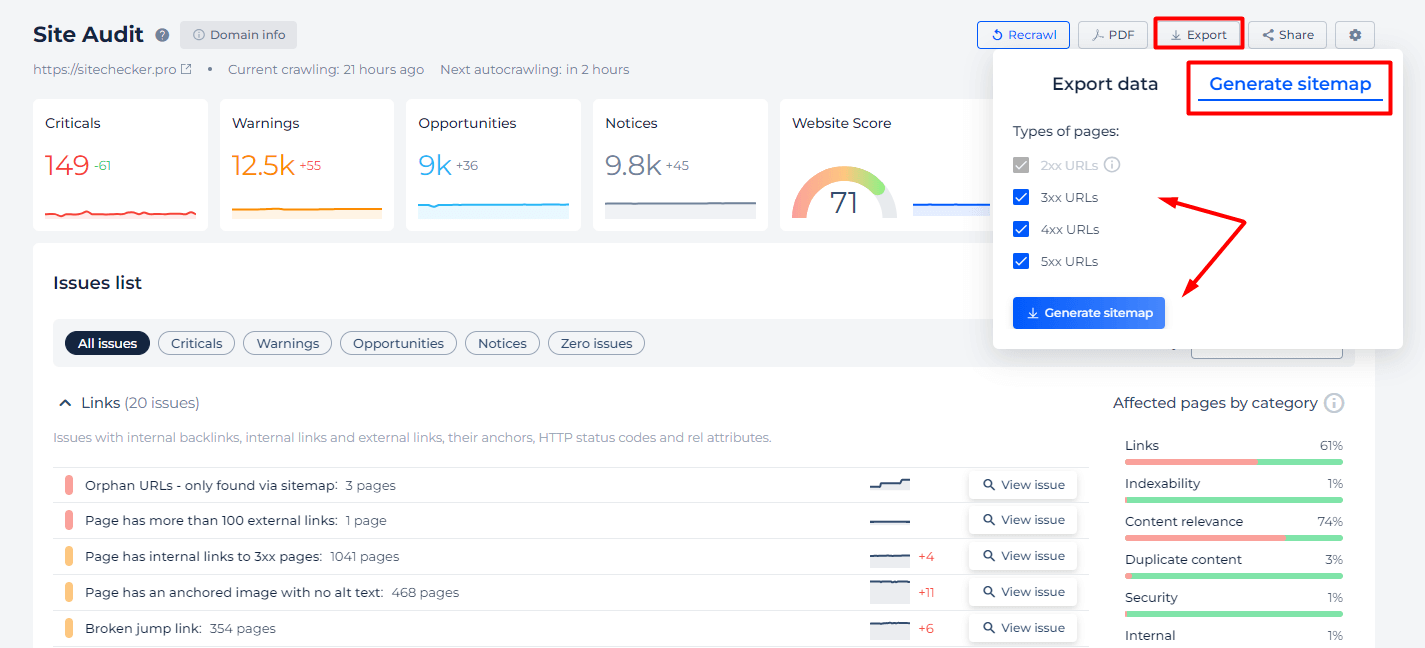

Além disso, oferecemos funcionalidades específicas no caso de não ter a certeza de que todas as páginas estão incluídas no seu mapa do site, ou se pretender simplesmente utilizar a nossa ferramenta como um validador de mapas do site XML. Utilize os separadores “Exportar” e “Gerar mapa do site” para selecionar os tipos de URLs por código de estado que devem ser incluídos no seu mapa.

Características adicionais do verificador de mapas do site XML

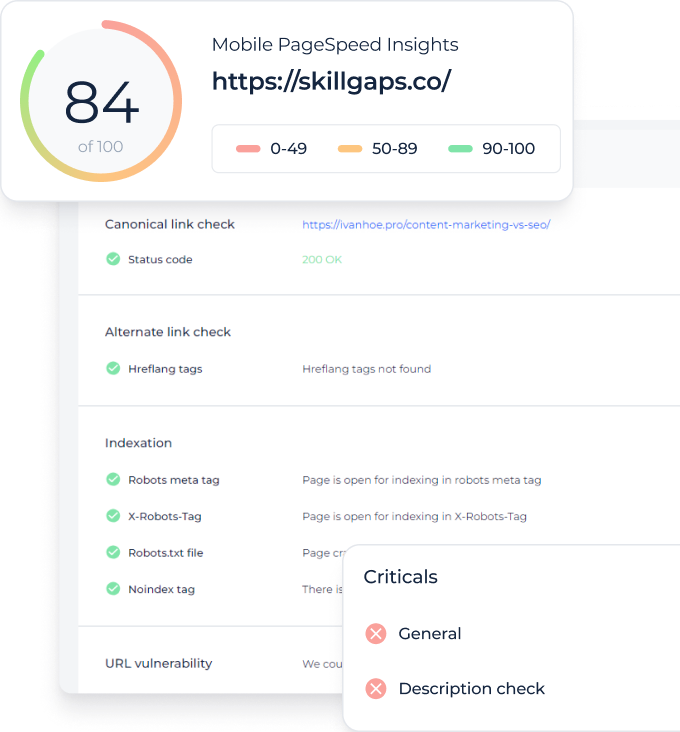

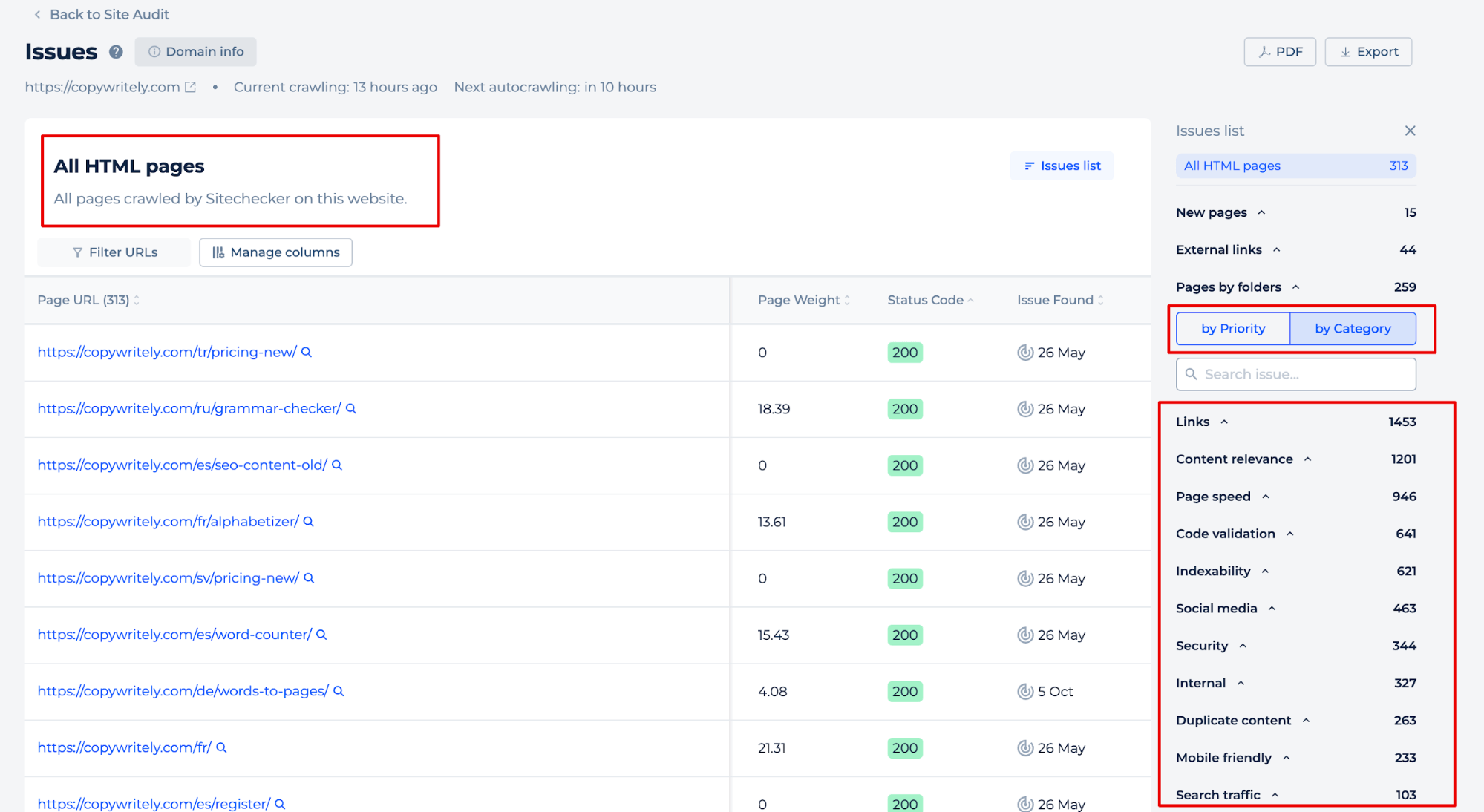

Após o rastreamento do site, você também receberá um relatório abrangente de auditoria do site, destacando quaisquer problemas potenciais e fornecendo instruções sobre como corrigi-los. O relatório é classificado por tipo ou categoria de problema, permitindo-lhe abordar eficientemente os problemas mais cruciais para o sucesso do seu site.

Ao clicar no botão “Ver todas as páginas”, pode identificar problemas em páginas individuais. Ordene os problemas por prioridades ou categorias ou adicione manualmente os dados às páginas que lhe interessam.

Ideia final

O Website Sitemap Checker é uma ferramenta concebida para garantir que um site tem um ficheiro XML, identificar quaisquer erros presentes e ajudar a melhorar a eficiência de indexação do motor de pesquisa do site. Oferece uma interface de fácil utilização num painel de controlo unificado para uma gestão SEO fácil, como parte de um conjunto completo de ferramentas SEO. A ferramenta simplifica o processo de verificação de um mapa do sítio, introduzindo um nome de domínio e analisando os resultados, que incluem um relatório de auditoria abrangente com instruções detalhadas sobre a correção dos problemas identificados. Isto ajuda a manter um site bem estruturado e optimizado para SEO.