Qu’est-ce qu’un vérificateur de sitemap ?

XML Sitemap Finder est un outil permettant de vérifier si un site dispose d’une carte XML.

Vous pouvez utiliser Google Sitemap Checker pour vérifier si votre site web possède une carte de site web XML et pour identifier les erreurs éventuelles. Si l’outil trouve des bogues, il vous indiquera comment les corriger.

Le vérificateur de sitemap XML peut vous aider dans plusieurs domaines clés:

- Il vérifie la présence d’un fichier XML sur votre site.

- Il détecte tout problème dans le fichier xml du plan de votre site.

- Il améliore l’efficacité avec laquelle les moteurs de recherche indexent votre site.

Caractéristiques principales de Sitemap Tester

Tableau de bord unifié. Un tableau de bord unifié fournit une vue unique des données techniques de référencement, ce qui facilite le suivi et la gestion de leurs performances.

Interface conviviale. L’interface conviviale facilite l’utilisation de Sitechecker, même si vous n’êtes pas un expert technique.

Outil SEO complet. L’outil de consultation du plan du site fait partie d’un ensemble complet d’outils de référencement qui peut vous aider à améliorer le classement de votre site web dans les pages de résultats des moteurs de recherche (SERP).

Comment utiliser l’outil de recherche de plan du site XML

Heureusement, il n’est pas nécessaire de vérifier manuellement le code de votre site web pour savoir s’il contient le fichier qui répertorie les pages essentielles d’un site web. Avec l’aide du Détecteur de plan du site, vous pouvez consulter n’importe quel site pour obtenir cette information.

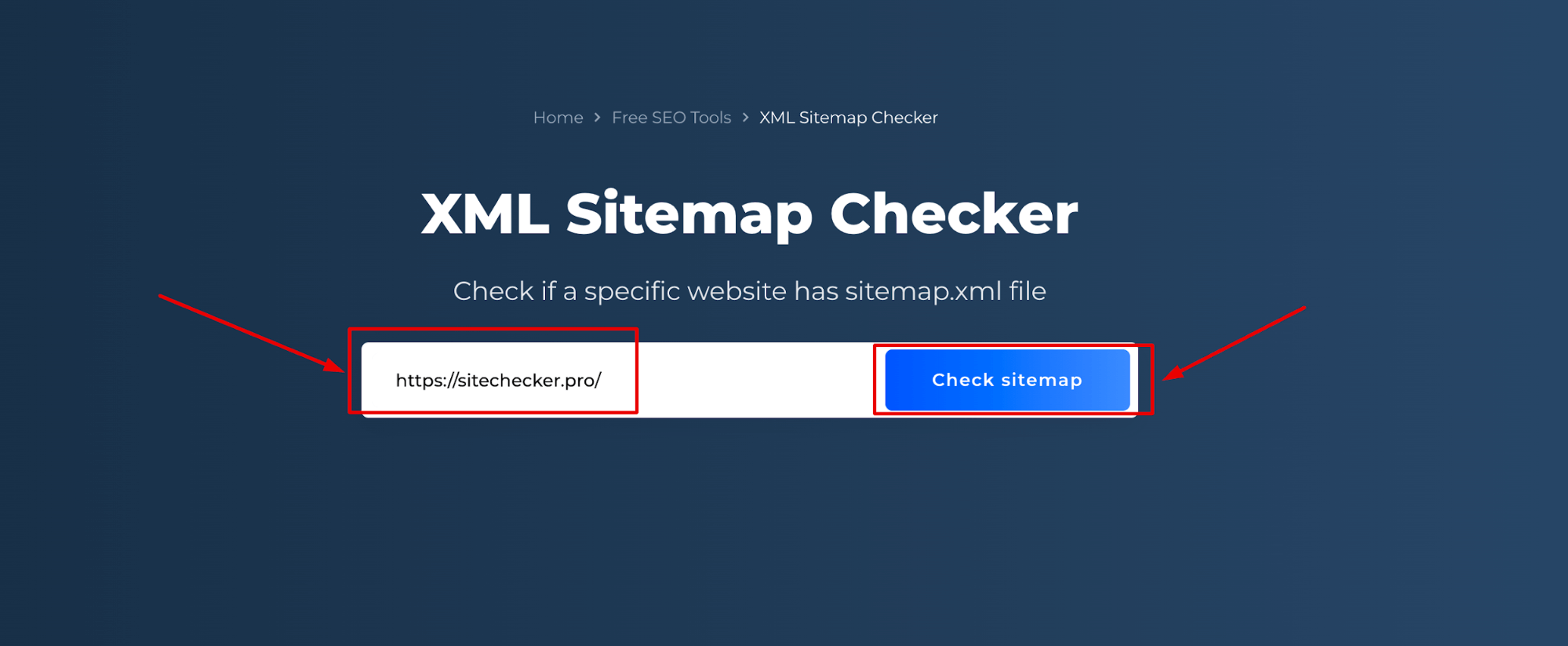

Étape 1 : Insérez votre nom de domaine

La première étape consiste à saisir l’URL de votre site web :

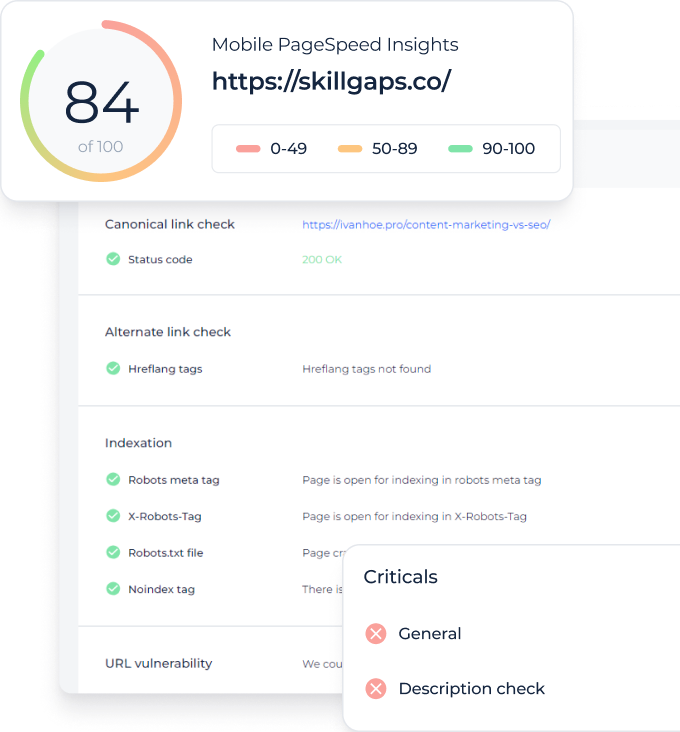

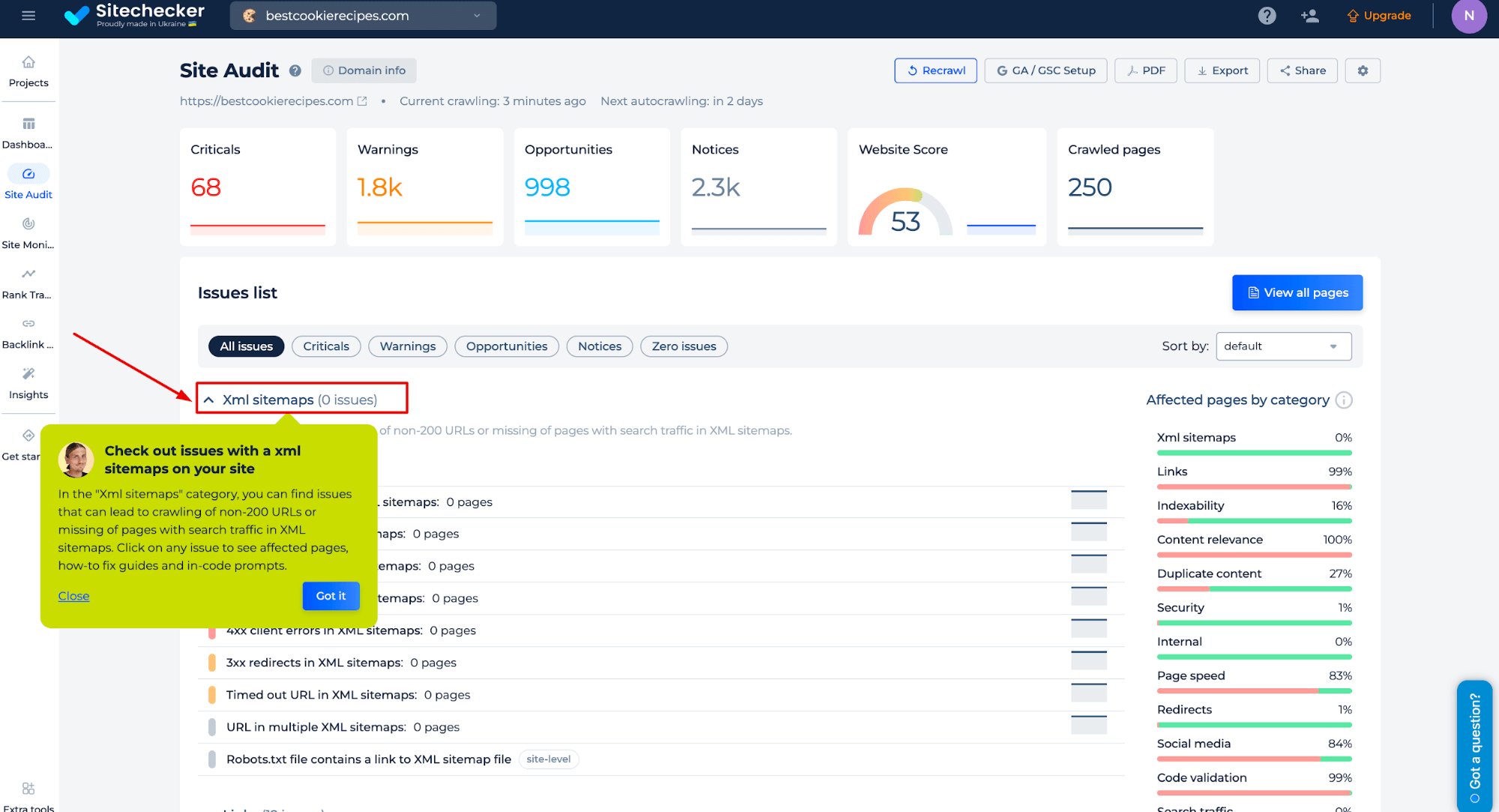

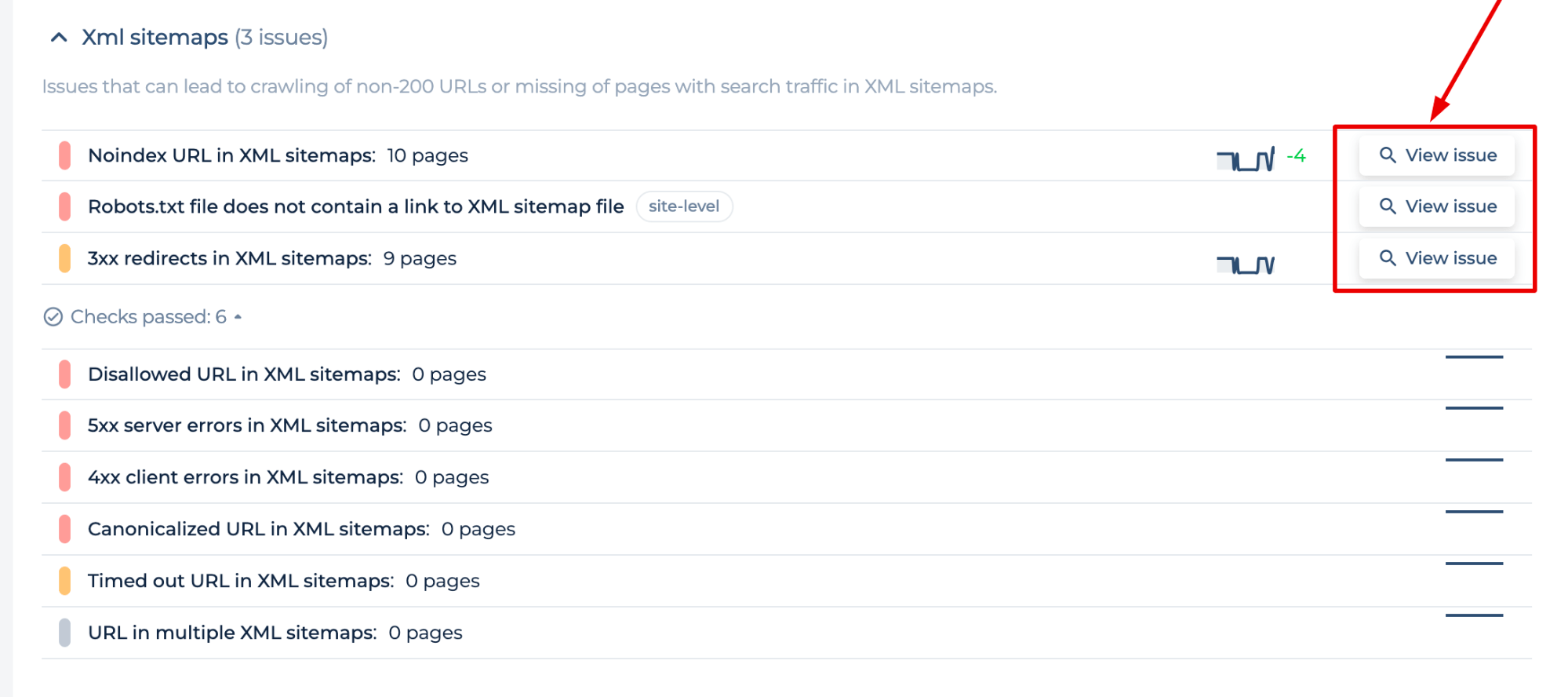

Etape 2 : Interprétation des résultats du testeur de sitemap

L’analyse que vous effectuez génère un audit du site pour le domaine que vous avez saisi. Dans la catégorie “XML sitemaps”, vous pouvez trouver des problèmes qui peuvent entraîner l’exploration d’URL non-200 ou l’absence de pages avec un trafic de recherche dans les cartes XML. Cliquez sur un problème pour voir les pages affectées, les guides de correction et les invites dans le code.

Le testeur de sitemap vous permet d’identifier les erreurs de sitemap et d’obtenir des instructions sur la manière de les résoudre afin de réduire l’impact des erreurs de sitemap sur votre indexation :

- Un code de statut URL non 2xx dans le plan du site (3xx redirects, 5xx server errors, 4xx errors)

- Noindex URL et Disallowed URL

- Fichier Robots.txt sans lien vers le sitemap XML, URL dans plusieurs XML, Fichier Sitemap.xml trop volumineux, etc.

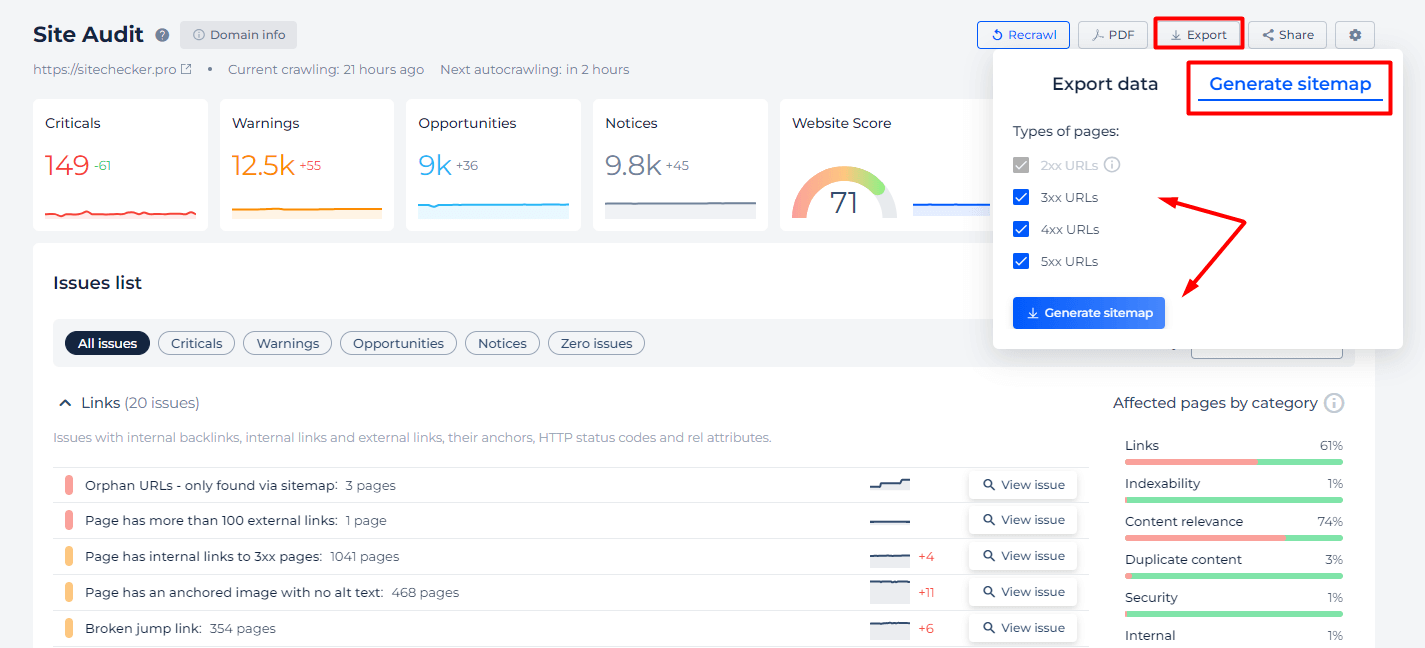

En outre, nous proposons des fonctionnalités spécifiques au cas où vous ne seriez pas certain que toutes les pages sont incluses dans votre sitemap, ou si vous souhaitez simplement utiliser notre outil en tant que validateur de sitemap XML. Utilisez les onglets “Exporter” et “Générer une sitemap” pour sélectionner les types d’URL par code de statut qui doivent être inclus dans votre carte.

Fonctionnalités supplémentaires du vérificateur de sitemap XML

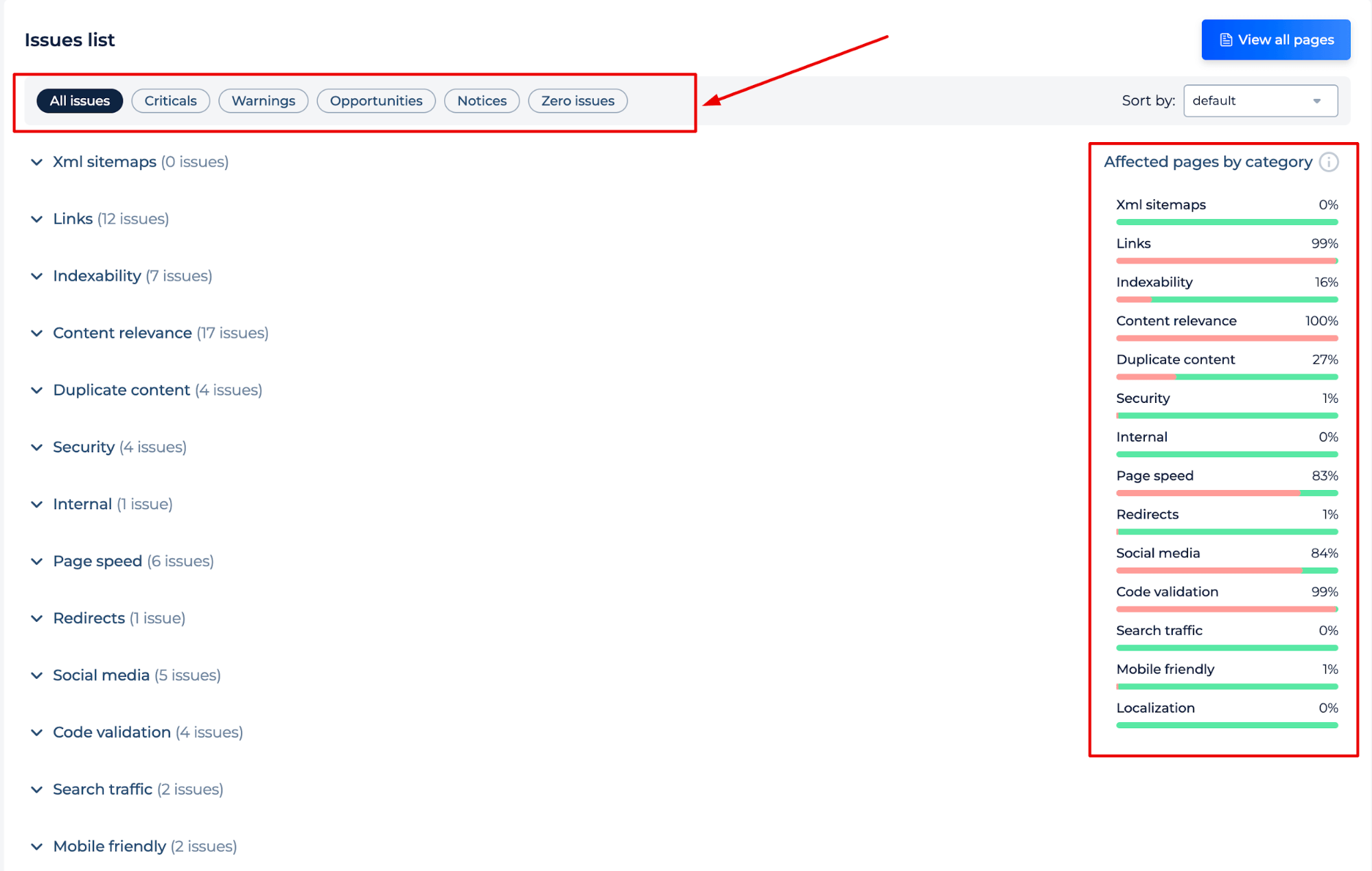

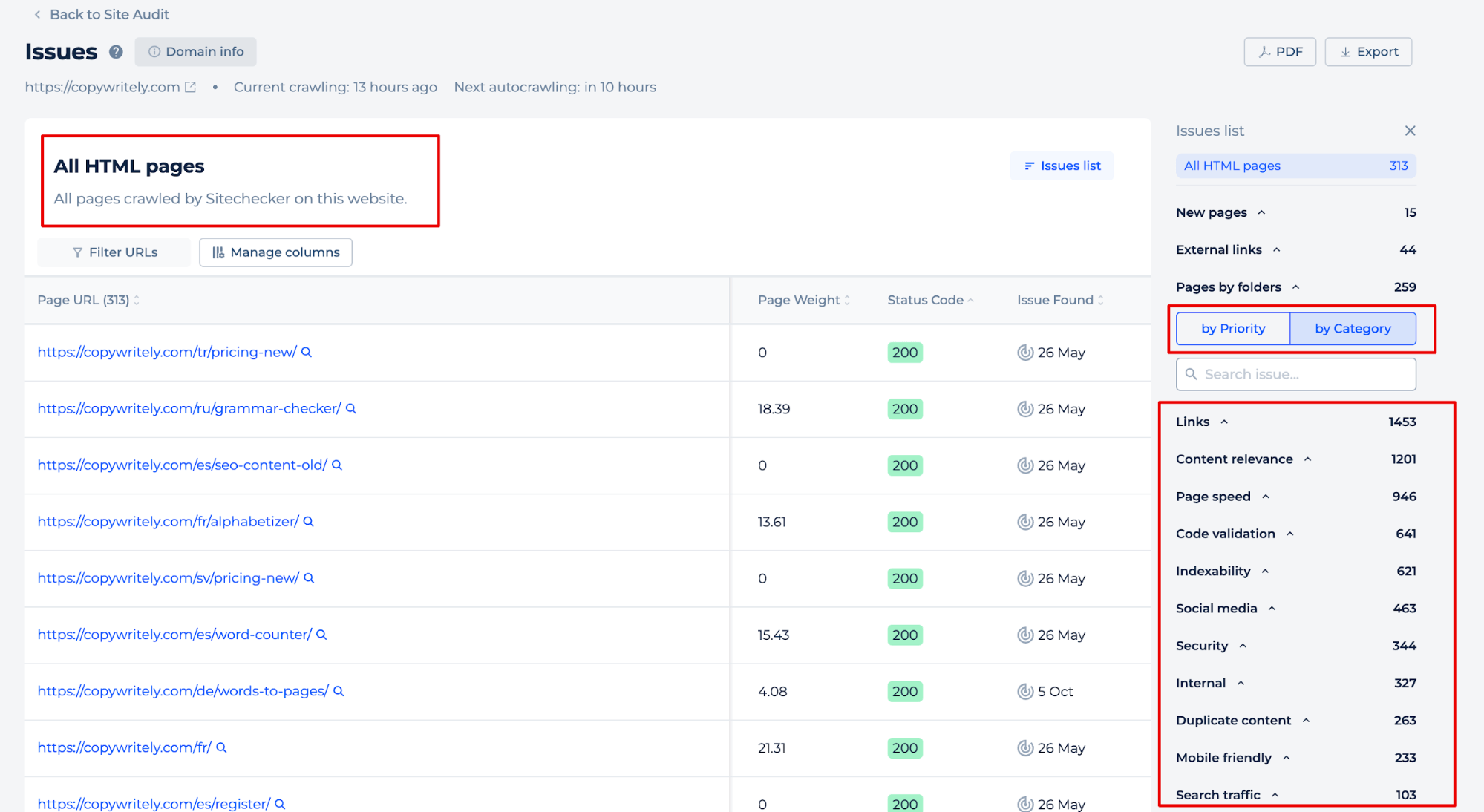

Après l’exploration du site, vous recevrez également un rapport d’audit complet du site, mettant en évidence tous les problèmes potentiels et fournissant des instructions sur la manière de les résoudre. Le rapport est trié par type ou catégorie de problème, ce qui vous permet d’aborder efficacement les questions les plus cruciales pour le succès de votre site.

En cliquant sur le bouton “Voir toutes les pages”, vous pouvez identifier les problèmes sur des pages individuelles. Triez les problèmes par priorité ou par catégorie, ou ajoutez manuellement des données aux pages qui vous intéressent.

Idée finale

Le vérificateur de sitemap est un outil conçu pour s’assurer qu’un site dispose d’un fichier XML, pour identifier les erreurs éventuelles et pour améliorer l’efficacité de l’indexation du site par les moteurs de recherche. Il offre une interface conviviale au sein d’un tableau de bord unifié pour une gestion facile du référencement, dans le cadre d’un ensemble complet d’outils de référencement. L’outil simplifie le processus de vérification d’un plan de site en entrant un nom de domaine et en analysant les résultats, qui comprennent un rapport d’audit complet avec des instructions détaillées sur la résolution des problèmes identifiés. Cela permet de maintenir un site bien structuré et optimisé pour le référencement.