Wat is een Sitemap Checker?

XML Sitemap Finder is een hulpmiddel om te controleren of een site een XML-map heeft.

U kunt Google Sitemap Checker gebruiken om te controleren of uw website een XML sitemap heeft en om eventuele fouten te identificeren. Als het hulpprogramma fouten vindt, vertelt het je hoe je deze kunt herstellen.

De XML Sitemap Checker kan u helpen op verschillende belangrijke gebieden:

- Het controleert de aanwezigheid van een XML-bestand op uw site.

- Het detecteert eventuele problemen binnen uw website map xml bestand.

- Het verbetert de efficiëntie waarmee zoekmachines uw site indexeren.

Het controleert de aanwezigheid van een XML-bestand op uw site.

Eigenschappen van Sitemap Tester

Geünificeerd dashboard. Een uniform dashboard biedt een enkele weergave van technische SEO-gegevens, waardoor het gemakkelijk is om hun prestaties te volgen en te beheren.

Gebruikersvriendelijke interface. De gebruiksvriendelijke interface maakt het gemakkelijk om Sitechecker te gebruiken, zelfs als u geen technisch expert bent.

Complete SEO Toolset. Het Sitemap Lookup Tool is onderdeel van een complete SEO toolset die u kan helpen uw website beter te laten scoren op de resultatenpagina’s van zoekmachines (SERP’s).

Hoe gebruikt u de XML Sitemapzoeker?

Gelukkig is het niet nodig om handmatig de code van uw website te controleren om te zien of deze het bestand heeft dat de essentiële pagina’s van een website opsomt. Met behulp van Sitemap Detector kunt u elke site opzoeken om deze informatie te krijgen.

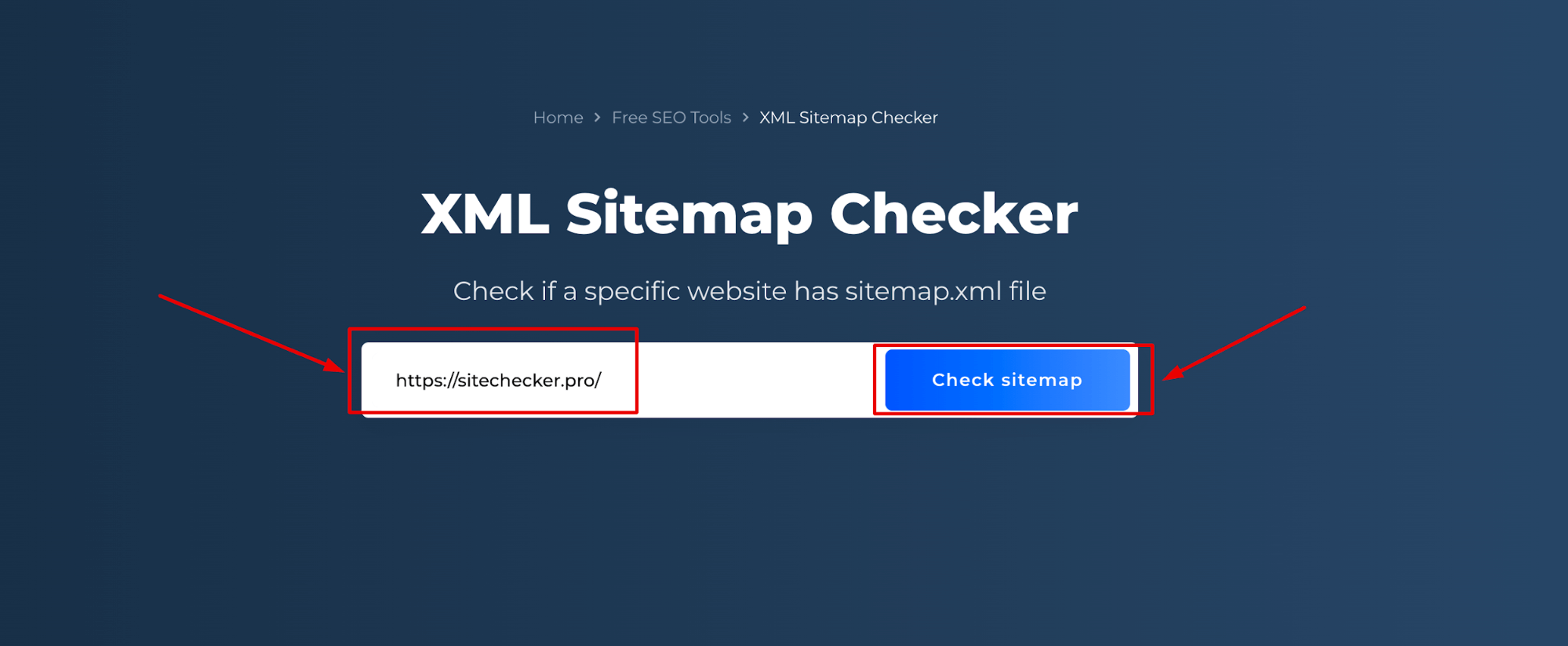

Stap 1: Voer uw domeinnaam in

De eerste stap is het invoeren van de URL van uw website:

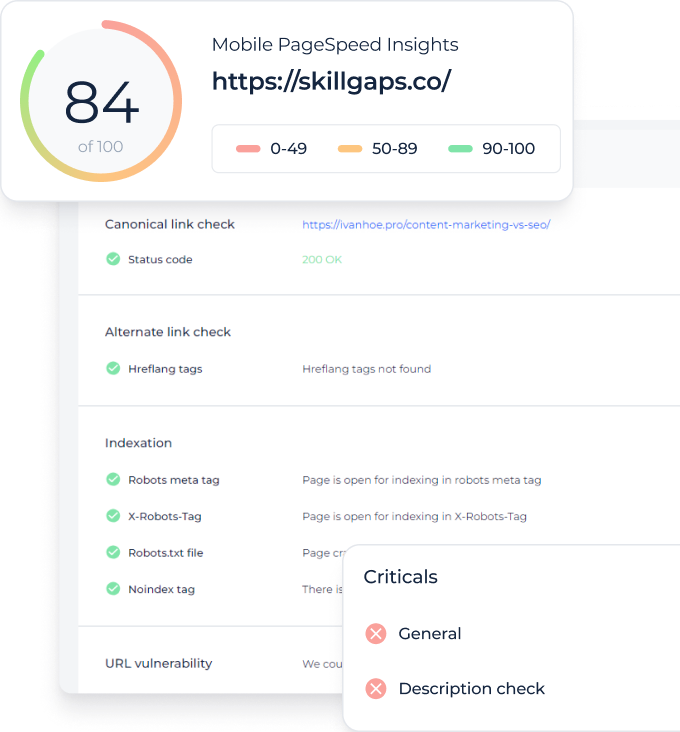

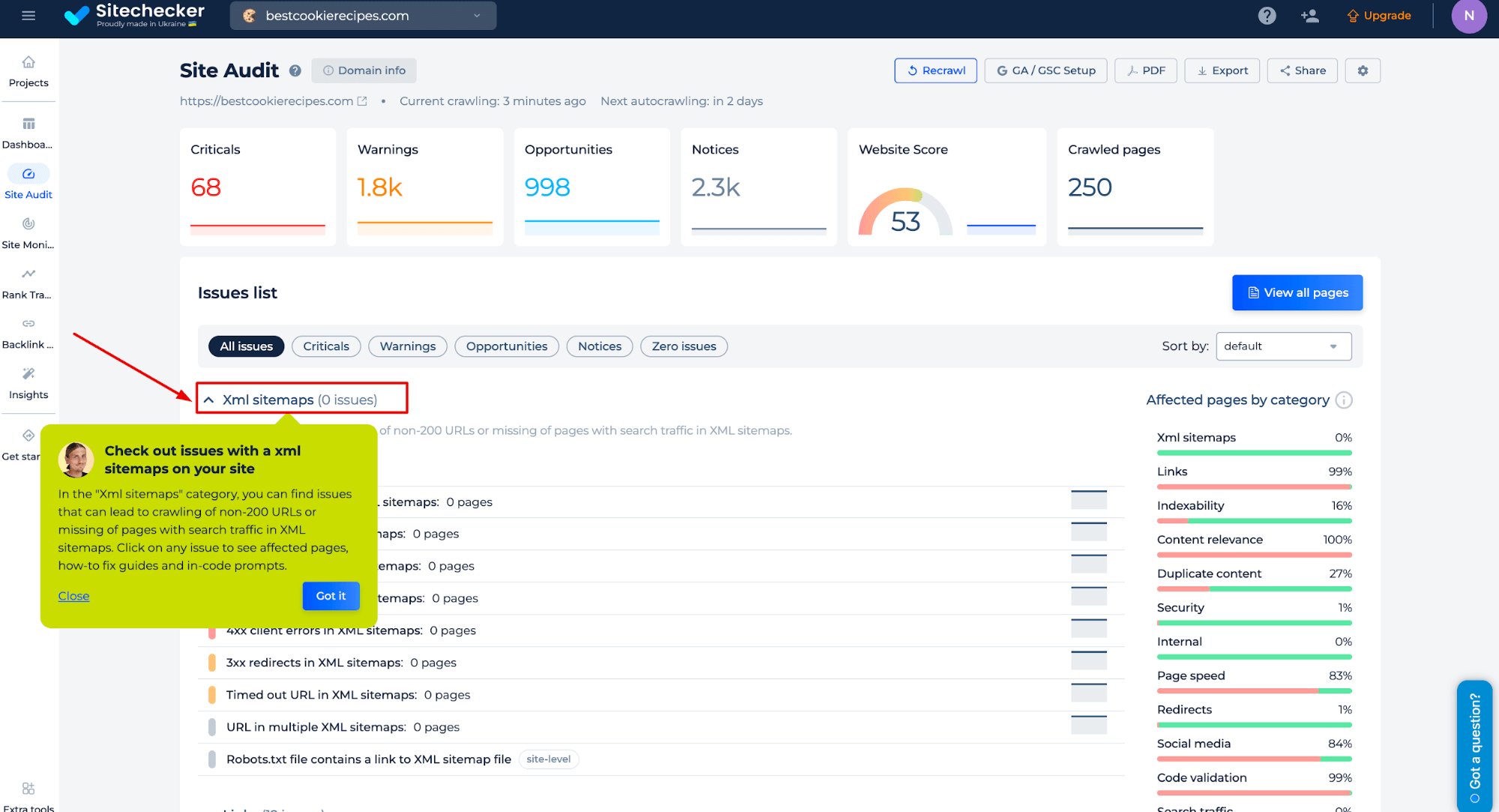

Stap 2: De resultaten van de Sitemap Tester interpreteren

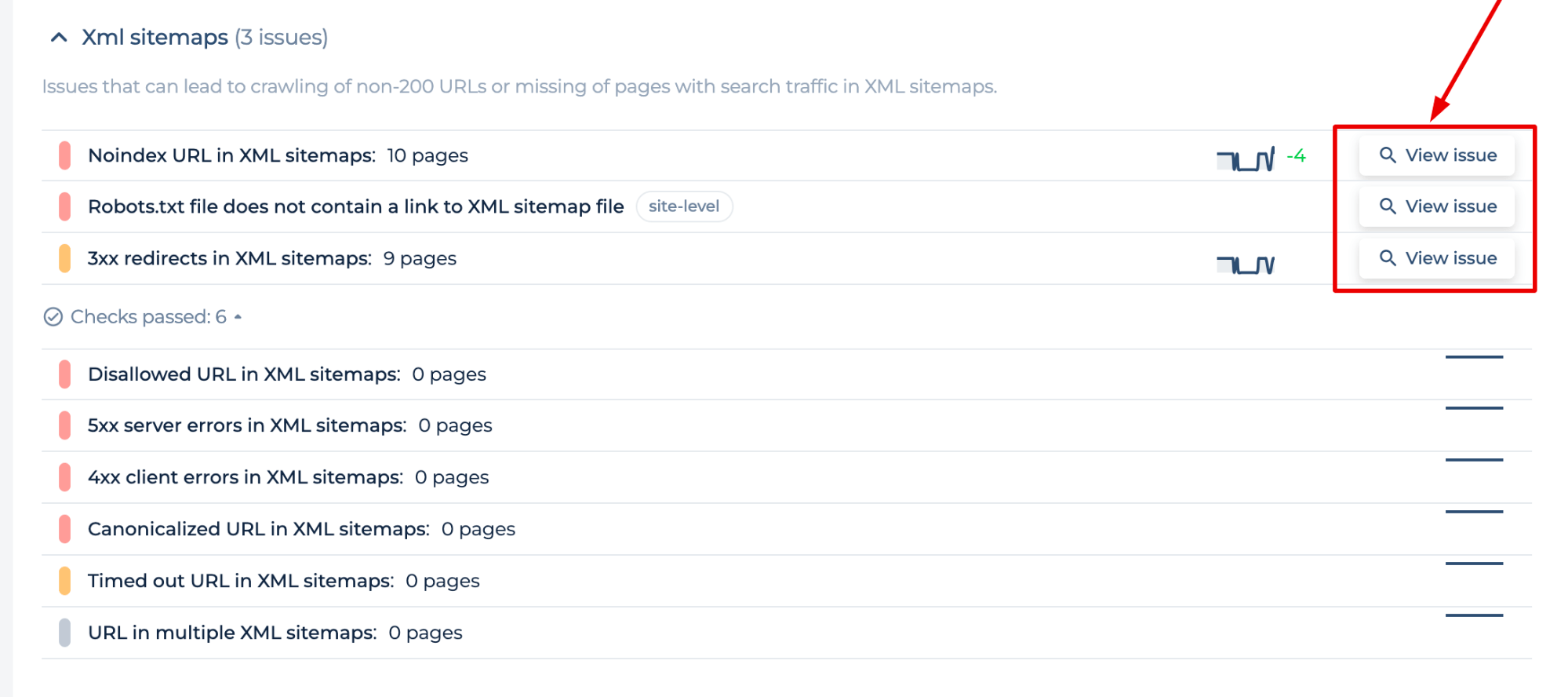

De scan die u uitvoert, genereert een site-audit voor het domein dat u opgeeft. In de categorie “XML-sitemaps” kunt u problemen vinden die kunnen leiden tot het crawlen van niet-200 URL’s of ontbrekende pagina’s met zoekverkeer in XML-maps. Klik op een probleem om de betreffende pagina’s, handleidingen voor het oplossen en aanwijzingen in de code te bekijken.

Met de sitemap tester kunt u sitemap fouten identificeren en instructies krijgen over hoe deze op te lossen om de invloed van sitemap fouten op uw indexering te verminderen:

- Niet 2xx status code URL in sitemap (3xx redirects, 5xx serverfouten, 4xx fouten)

- Noindex URL en niet toegestane URL

- Robots.txt bestand zonder link naar XML sitemap, URL in meerdere XML, Te groot Sitemap.xml bestand, etc.

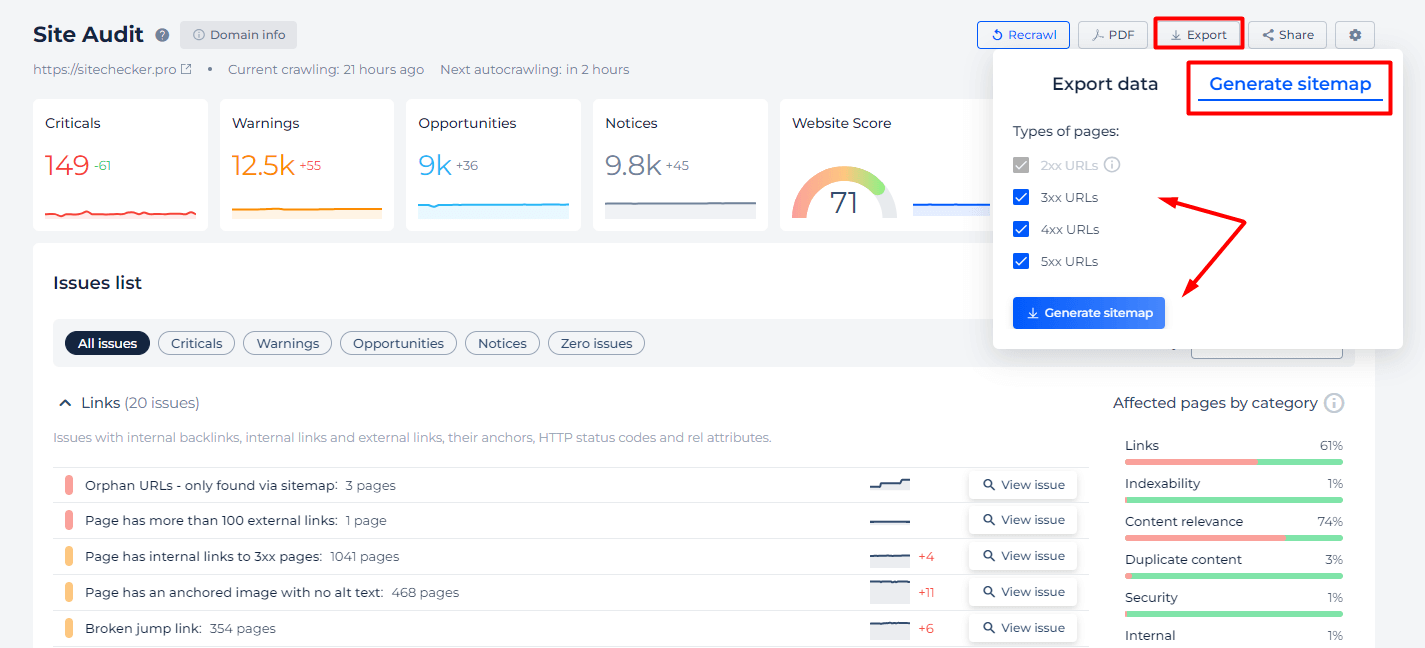

Daarnaast bieden we specifieke functies voor het geval je niet zeker weet of alle pagina’s zijn opgenomen in je sitemap, of als je onze tool gewoon wilt gebruiken als een XML sitemap validator. Gebruik de tabbladen “Export” en “Sitemap genereren” om de typen URL’s te selecteren op statuscode die opgenomen moeten worden in uw sitemap.

Extra functies van XML sitemap checker

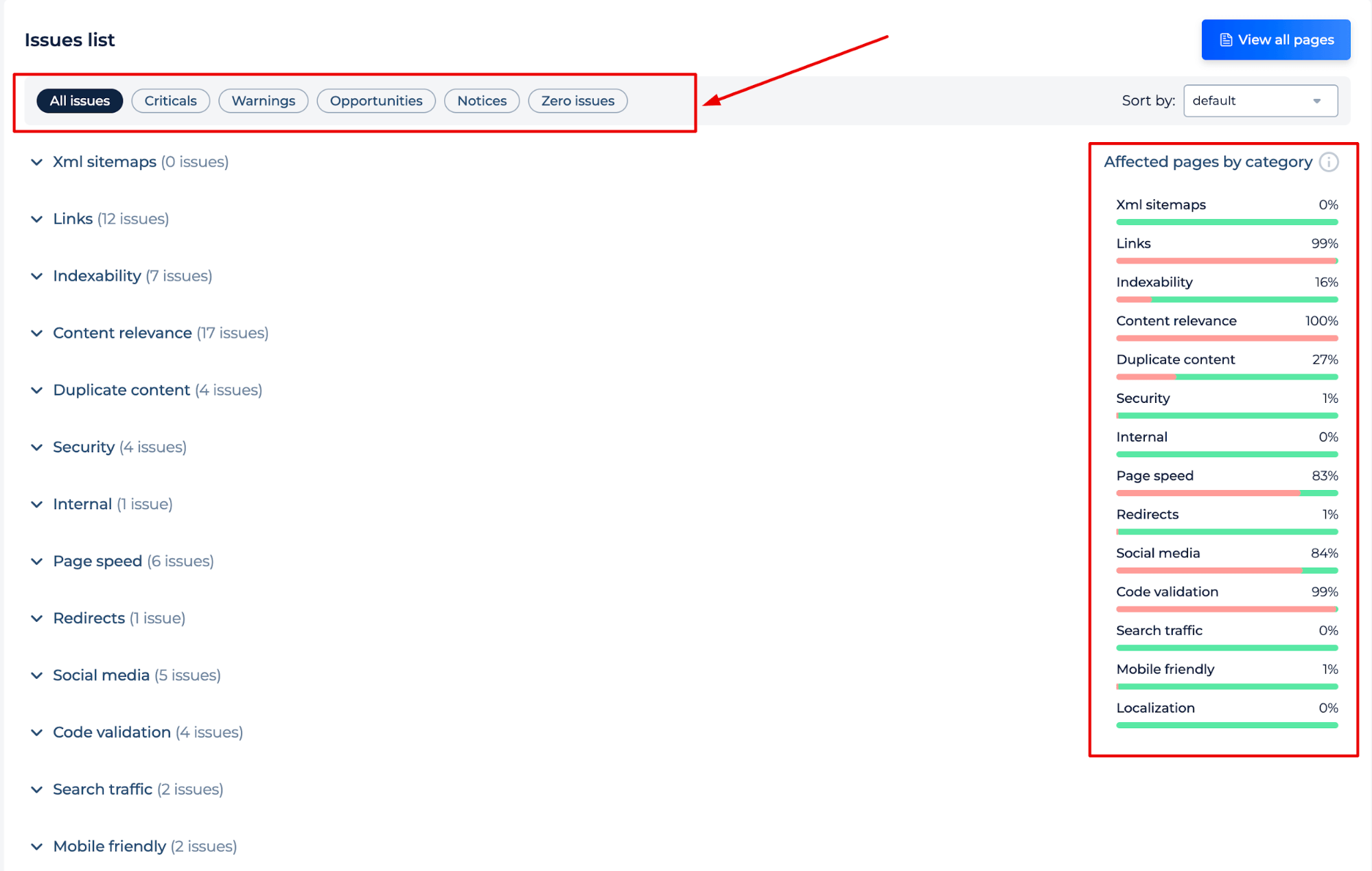

Na het crawlen van de site ontvangt u ook een uitgebreid auditrapport van de site, waarin potentiële problemen worden aangegeven en instructies worden gegeven voor het oplossen ervan. Het rapport is gesorteerd op probleemtype of categorie, zodat u efficiënt de meest cruciale problemen voor het succes van uw site kunt aanpakken.

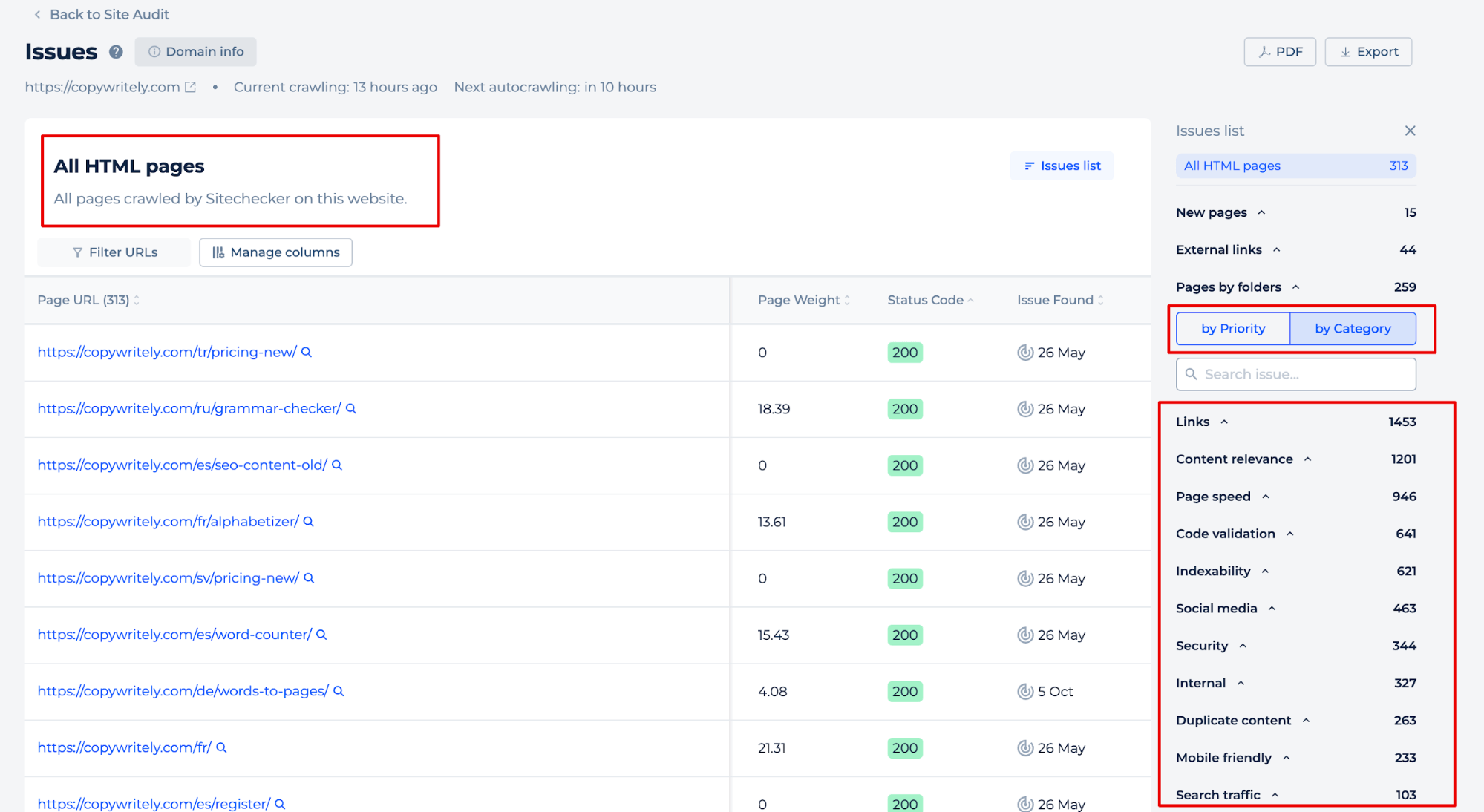

Door op de knop ‘Alle pagina’s weergeven’ te klikken, kunt u problemen op afzonderlijke pagina’s identificeren. Sorteer problemen op prioriteit of categorie of voeg handmatig gegevens toe aan de pagina’s waarin u geïnteresseerd bent.

Eindidee

De Website Sitemap Checker is een hulpmiddel dat is ontworpen om te controleren of een site een XML-bestand heeft, eventuele fouten te identificeren en de efficiëntie van de zoekmachine-indexering van de site te verbeteren. Het biedt een gebruiksvriendelijke interface binnen een uniform dashboard voor eenvoudig SEO-beheer, als onderdeel van een complete SEO-toolset. De tool vereenvoudigt het proces van het controleren van een sitemap door het invoeren van een domeinnaam en het analyseren van de resultaten, waaronder een uitgebreid auditrapport met gedetailleerde instructies voor het oplossen van geïdentificeerde problemen. Dit helpt bij het onderhouden van een goed gestructureerde en SEO-geoptimaliseerde site.