O que é o Robots.txt Tester?

A ferramenta Robots.txt Tester do Sitechecker foi concebida para validar o ficheiro de um site, garantindo que os bots de motores de busca compreendem quais as páginas que devem ser indexadas ou ignoradas. Isto facilita a gestão eficiente da visibilidade de um website nos resultados de pesquisa. A ferramenta oferece verificações abrangentes do website para identificar problemas de indexação e também fornece verificações específicas da página para determinar se uma página está indexada. Isto aumenta a precisão da indexação do motor de busca ao identificar e corrigir rapidamente quaisquer erros nas definições do ficheiro robots.txt.

Como é que a ferramenta o pode ajudar?

Validação do ficheiro Robots.txt: verifica a exatidão do ficheiro robots.txt de um website, garantindo que este direciona com precisão os robôs dos motores de busca.

Verificações específicas de página: oferece a capacidade de verificar se as páginas individuais estão indexadas corretamente ou não, permitindo a resolução de problemas direcionada.

Identificação de problemas de indexação: fornece verificações abrangentes para detetar quaisquer problemas de indexação em todo o website.

Principais funcionalidades da ferramenta

Painel unificado:oferece uma visão geral abrangente das métricas de SEO para uma fácil monitorização.

Interface de fácil utilização: concebida para uma navegação intuitiva e facilidade de utilização.

Conjunto completo de ferramentas de SEO: fornece uma vasta gama de ferramentas para otimizar o desempenho do website nos motores de busca.

Como utilizar a ferramenta

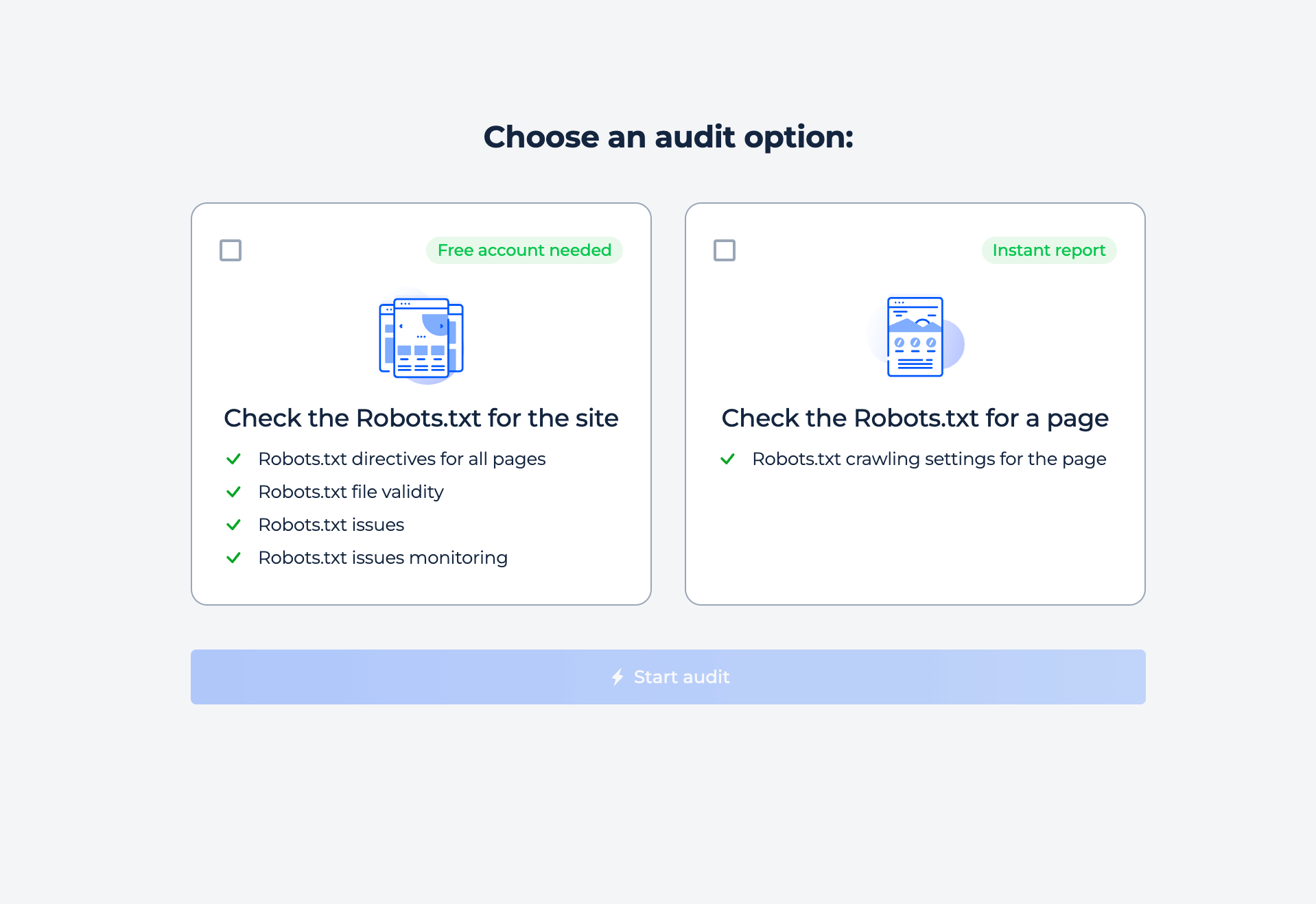

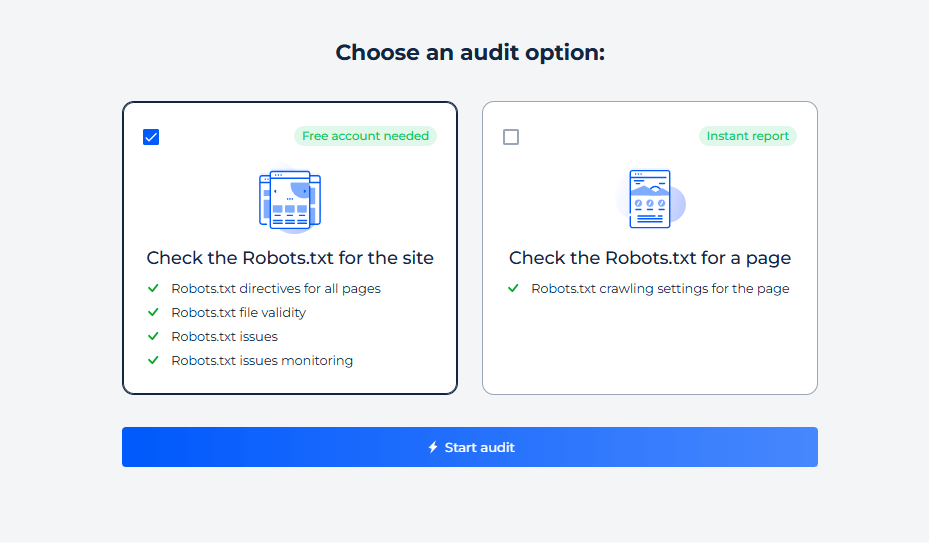

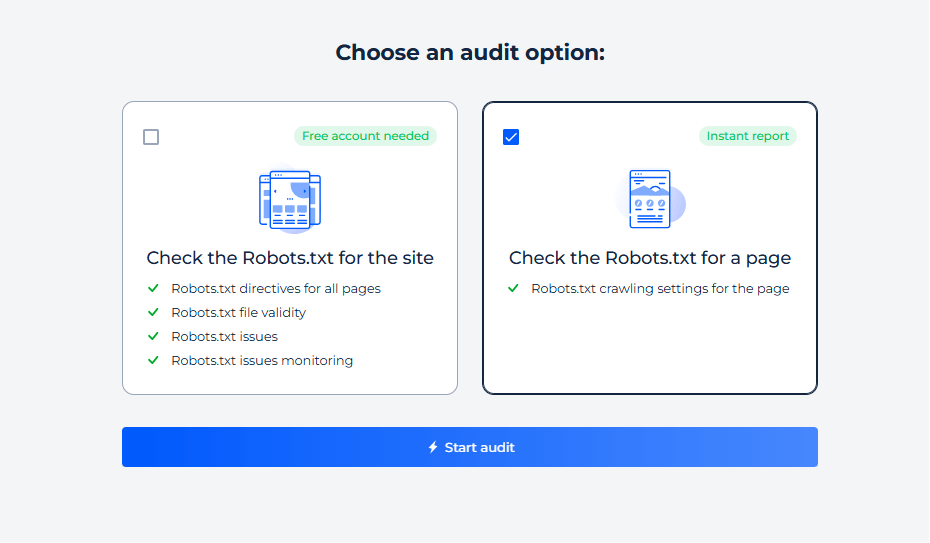

A ferramenta oferece dois tipos de digitalização online: site inteiro e página individual. Basta selecionar a opção do seu interesse e iniciar a digitalização.

Teste do ficheiro Robots.txt do site

Para verificar as definições do robô do seu site e descobrir quaisquer problemas de indexação, basta selecionar a opção de inspeção do site. Em minutos, receberá um relatório completo.

Passo 1: Escolha a verificação do site

Passo 2: Obter os resultados

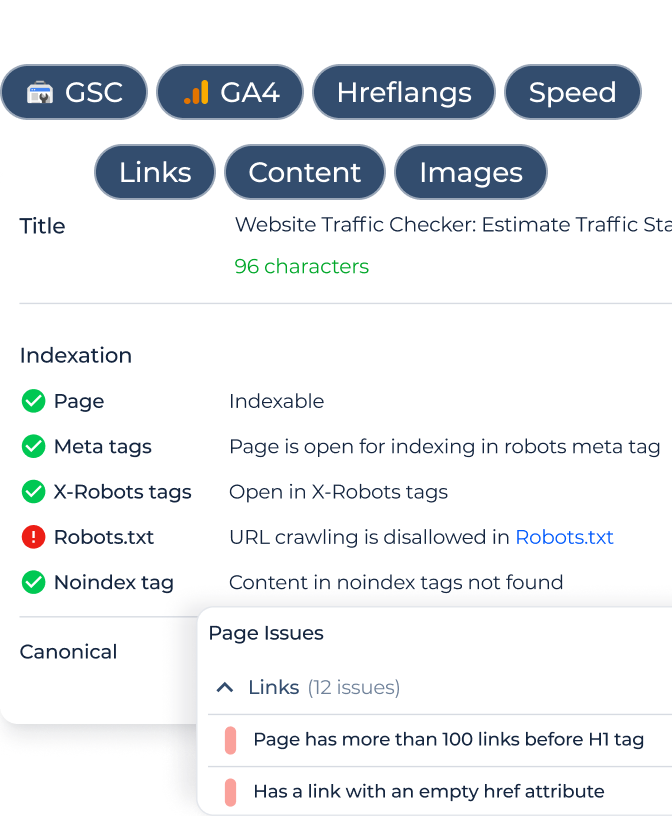

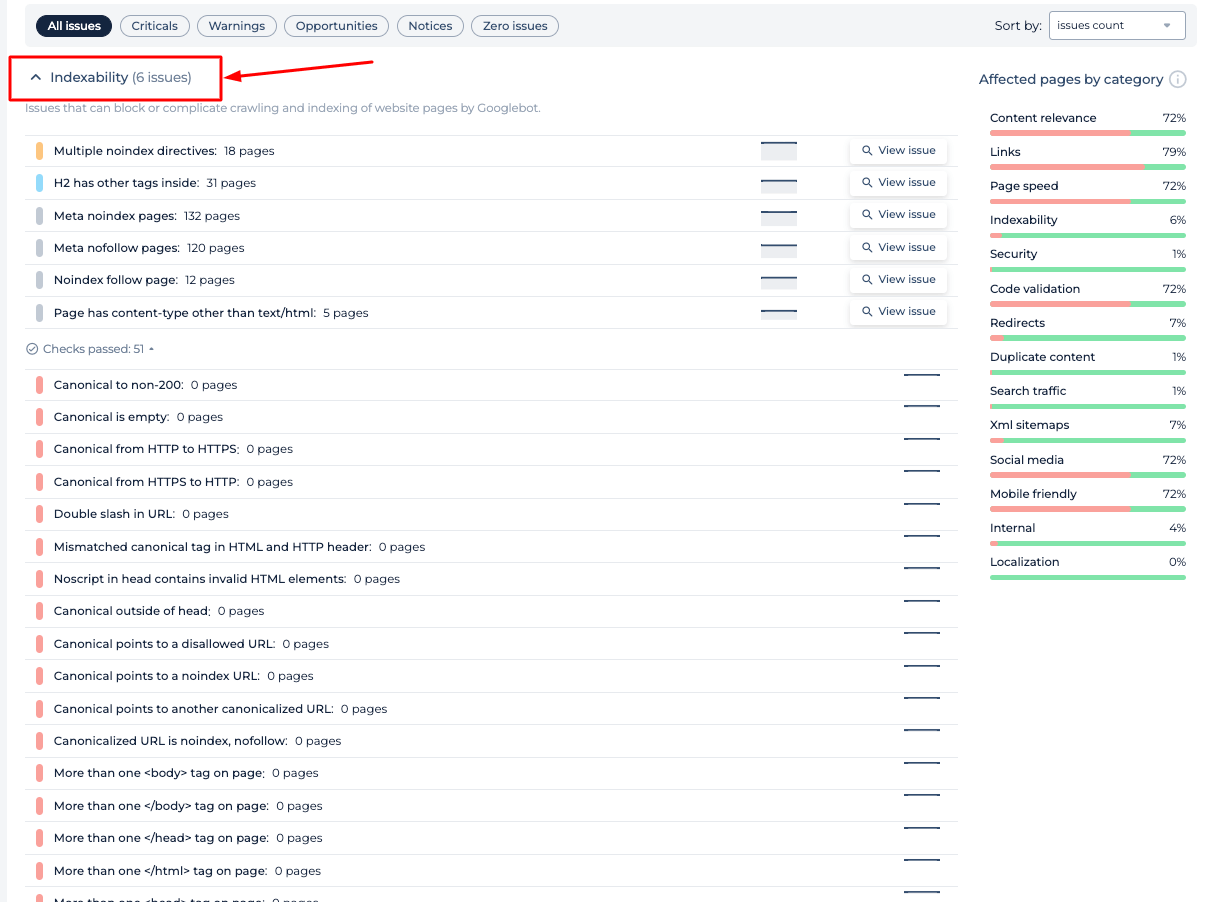

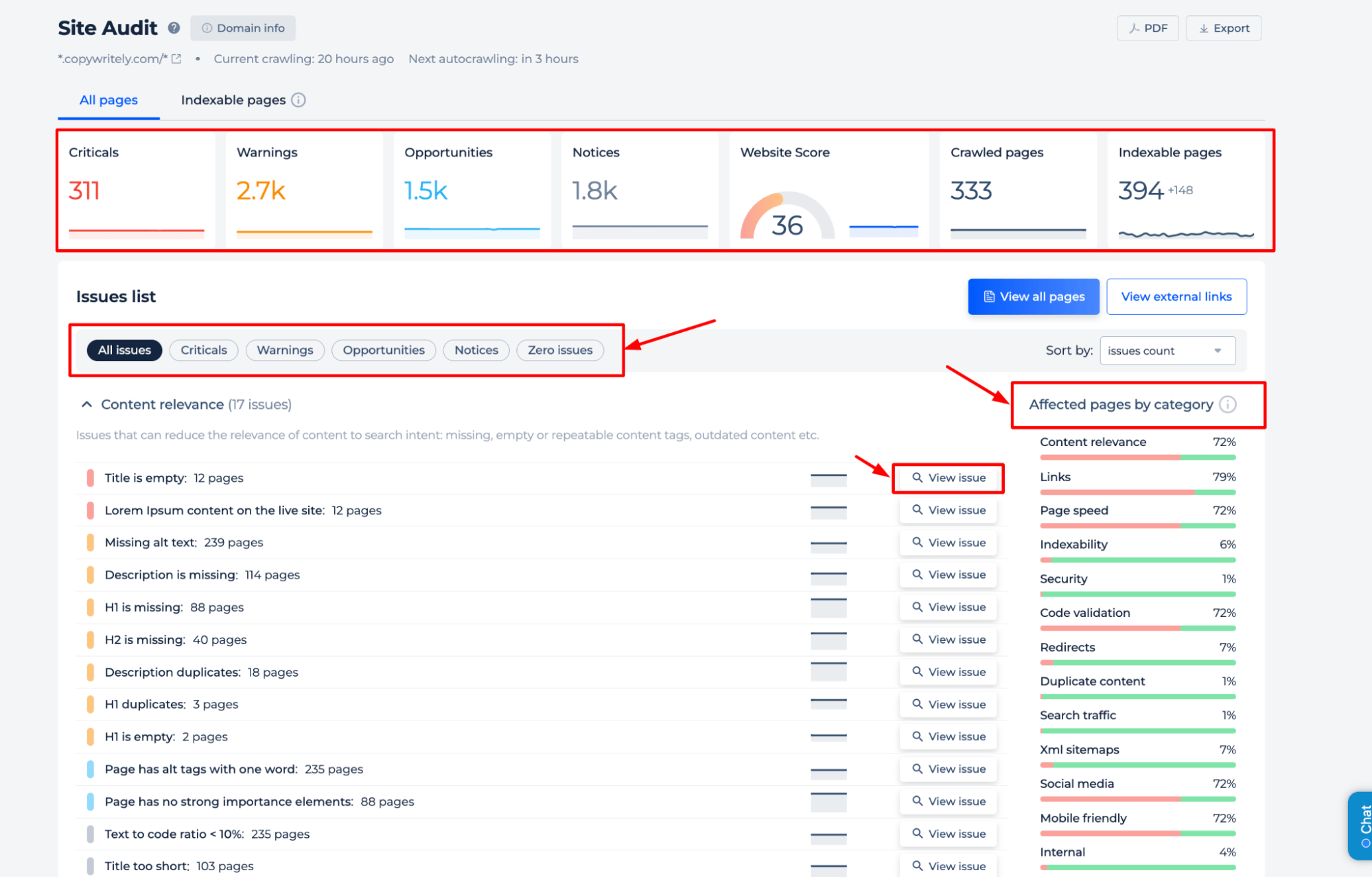

O Robots.txt Analyser para avaliar a configuração do ficheiro de diretivas do servidor, fornece dados valiosos sobre a forma como as diretivas do site influenciam a indexação do motor de busca. O relatório inclui a identificação de páginas bloqueadas para rastreio, diretivas específicas como ‘noindex’ e ‘nofollow’ e quaisquer atrasos de rastreio definidos para os robôs dos motores de busca. Isto ajuda a garantir que o ficheiro de política de rastreio do website está a facilitar a visibilidade ideal do website e a acessibilidade do motor de busca.

Recursos adicionais

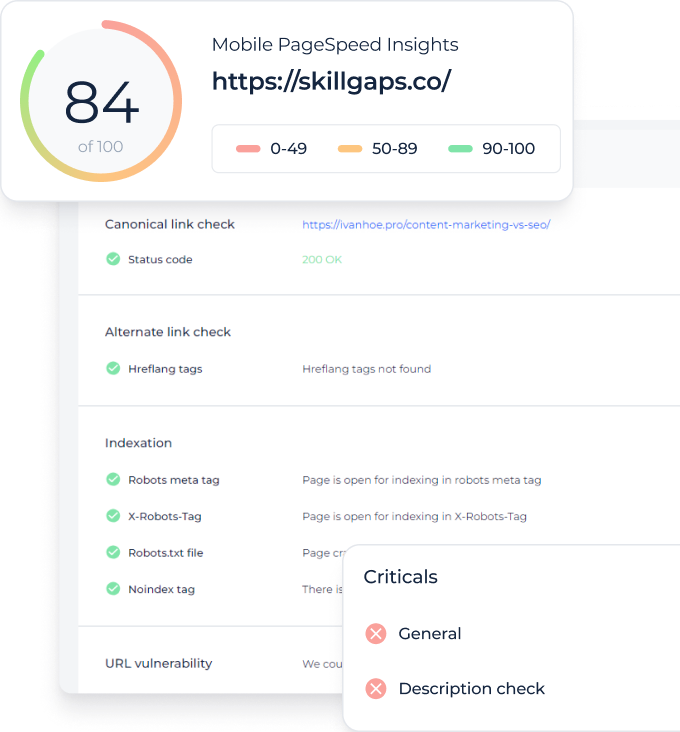

O Robots.txt Checker oferece uma análise abrangente da saúde SEO de um website. Identifica problemas críticos, avisos, oportunidades de melhoria e avisos gerais. São fornecidos insights detalhados sobre a relevância do conteúdo, integridade do link, velocidade da página e indexabilidade. A auditoria categoriza as páginas afetadas, permitindo aos utilizadores priorizar as otimizações para uma melhor visibilidade nos motores de busca. Esta funcionalidade complementa o Verificador Robots.txt, garantindo que elementos mais amplos de SEO também são abordados.

Teste Robots.txt para uma página específica

Passo 1: iniciar uma verificação para uma página específica

Passo 2: obter os resultados

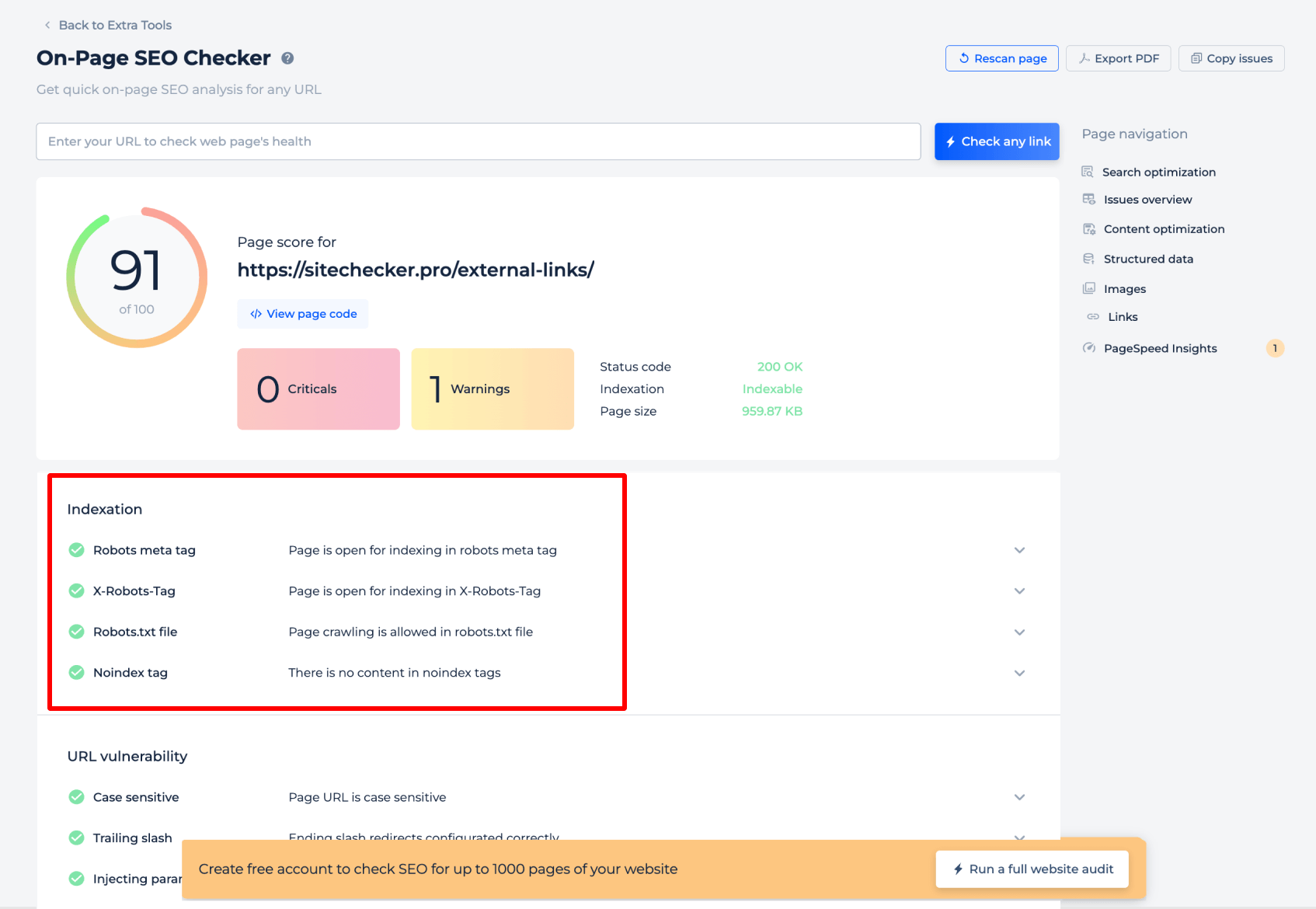

O testador Robots.txt para uma página específica fornece informações críticas sobre a forma como os motores de busca interpretam as diretivas robots.txt para essa página. Analisa a meta tag robots e a X-Robots-Tag para confirmar se a página está aberta para indexação. Além disso, verifica se o rastreio é permitido pelo ficheiro de política de rastreio do site e verifica a presença de tags ‘noindex’ que podem impedir a indexação. Esta avaliação focada garante que cada página está configurada corretamente para ser acessível aos robôs dos motores de busca.

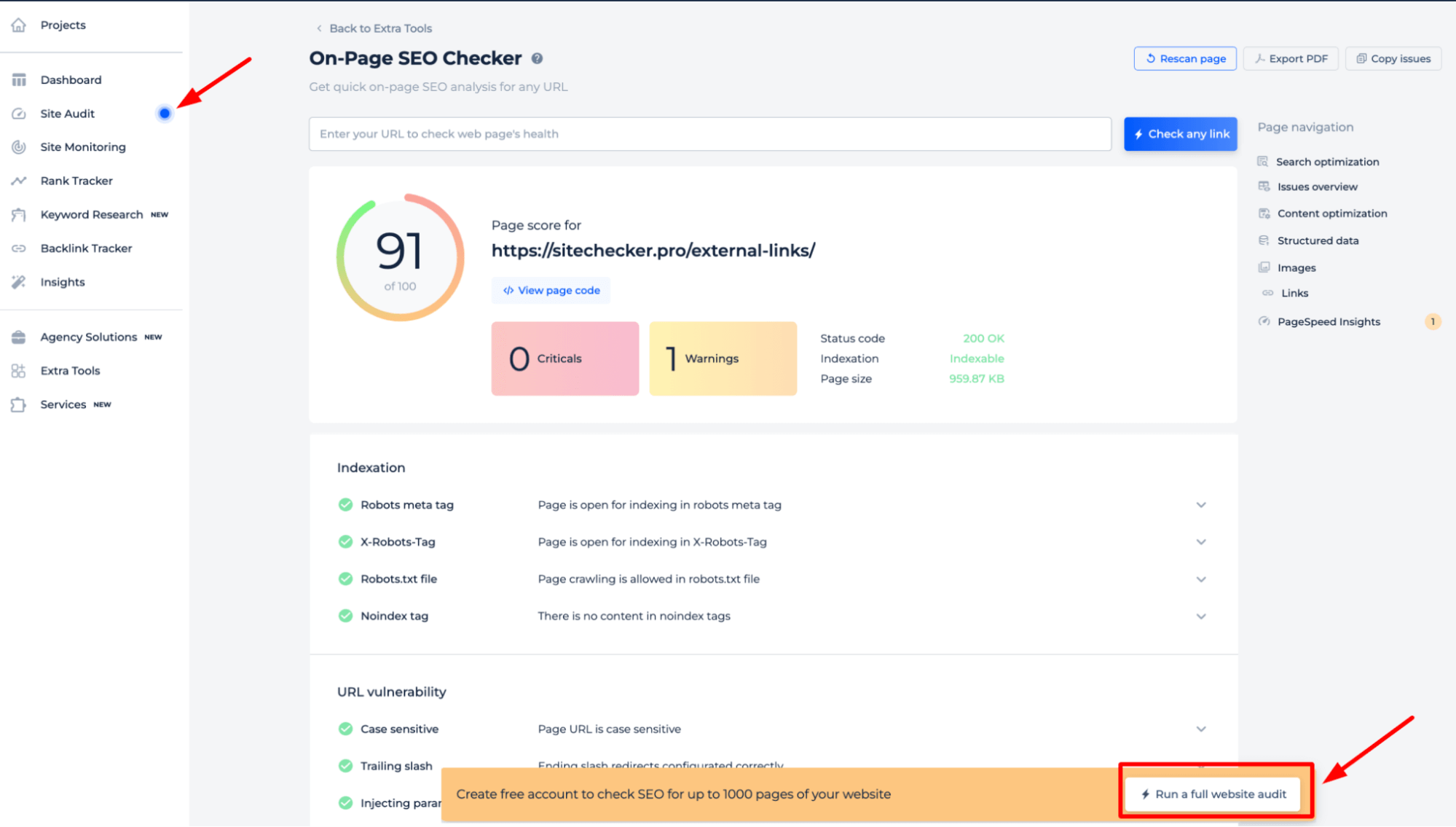

Para obter uma compreensão abrangente das diretivas robots.txt do seu website, é melhor realizar uma auditoria completa do website. Isto revelará quaisquer problemas de indexação no seu site. Para iniciar a auditoria, basta clicar no banner “Iniciar auditoria completa do site”. Uma versão de demonstração da ferramenta pode ser acedida na secção Auditoria do Site, permitindo experimentar as suas funcionalidades.

Recursos adicionais

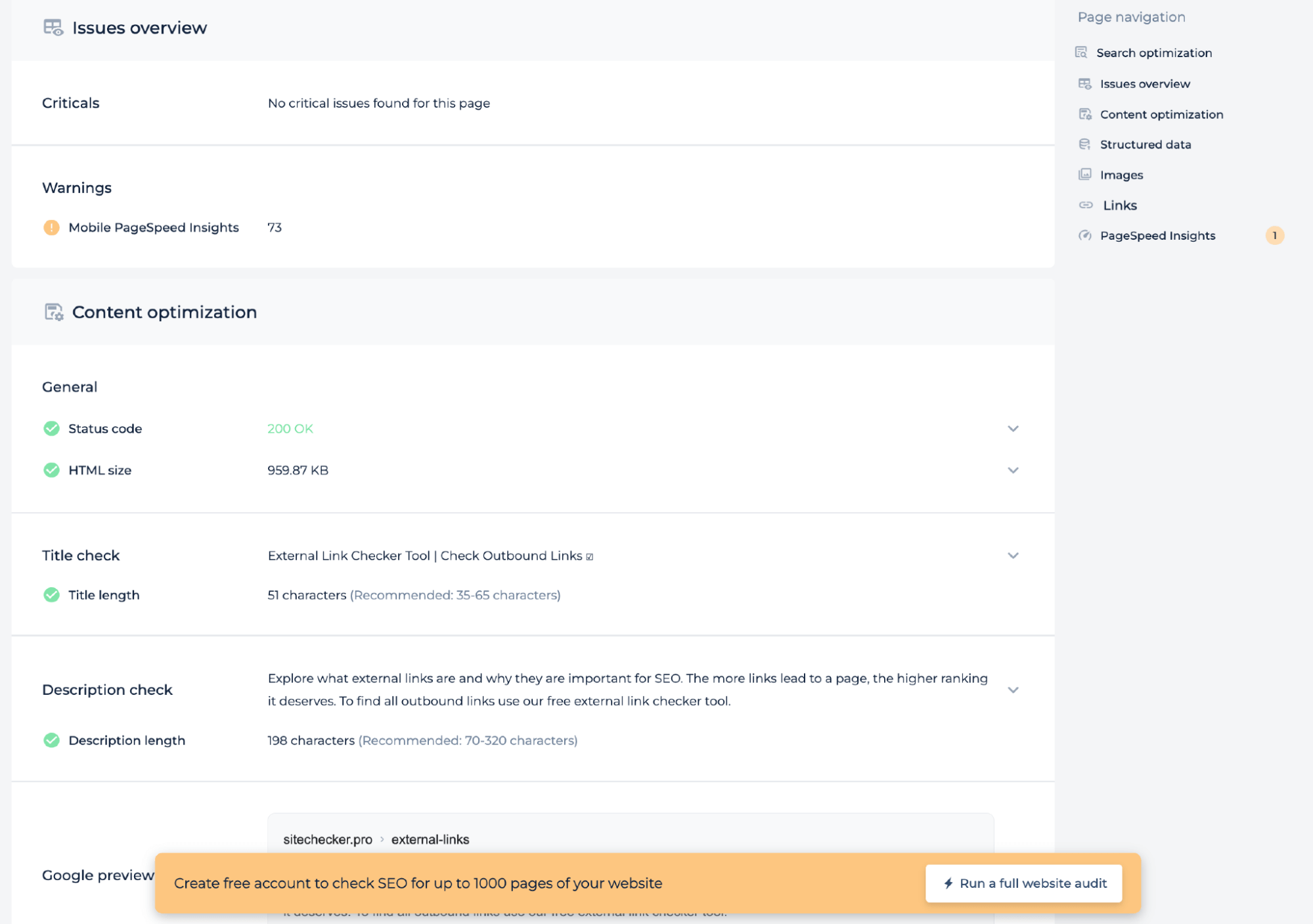

Além de testar o ficheiro de diretivas do servidor para uma página específica, a auditoria técnica fornece informações sobre a integridade da página, como a pontuação do PageSpeed para dispositivos móveis, o código de estado e o tamanho do HTML. Verifica se os comprimentos do título e da descrição cumprem os padrões recomendados e oferece uma visualização do Google para garantir que a página está otimizada para os motores de busca. Esta análise ajuda a melhorar o SEO técnico da página.

Ideia final

O Robots.txt Tester é uma ferramenta de diagnóstico SEO robusta que garante que o ficheiro de diretivas do servidor de um website está a direcionar os robôs dos motores de busca corretamente. Oferece varreduras completas do site e de páginas específicas, revelando quaisquer barreiras de indexação. Os utilizadores beneficiam de uma interface de fácil utilização, um amplo conjunto de ferramentas de SEO e um painel unificado para monitorização. As abrangentes capacidades de auditoria da ferramenta permitem a identificação de uma vasta gama de problemas técnicos de SEO, incluindo a otimização do conteúdo e as métricas de saúde da página, garantindo que cada página está preparada para descoberta e classificação nos motores de busca.