Qu’est-ce qu’un outil de test de vitesse de page de site?

La vitesse de chargement de votre site est un paramètre crucial pour le classement des moteurs de recherche. Nous avons créé un test de vitesse de site Web afin que vous puissiez analyser la vitesse de chargement de votre site. Vous pouvez l’utiliser pour accélérer la charge de votre ressource et comprendre les causes du ralentissement de votre site.

Le test de vitesse du site Web est facile à utiliser et conviendra aux débutants comme aux utilisateurs plus expérimentés. Saisissez l’opportunité avec ce vérificateur de vitesse gratuit d’en savoir plus sur les points faibles de votre site qui vous empêchent d’augmenter la vitesse de chargement des pages.

Nous avions l’intention de créer un outil parfait pour tester la vitesse du site Web et aider les webmasters et les développeurs Web à vérifier les performances du site Web.

Et nous l’avons fait !

Examinons de plus près les raisons pour lesquelles votre site peut être lent à se charger. Utilisez notre outil pour vérifier les principaux indicateurs de vitesse de votre ressource, car c’est le problème lorsque les pages ont une vitesse de chargement lente qui doit être résolu.

La vitesse du site Web affecte votre entreprise

- 8% de pages vues en moins après seulement 3 secondes d’attente.

- Baisse de 16% de la satisfaction client après seulement 1 seconde de retard.

- 32% correspond à la probabilité de taux de rebond après un délai de 3 secondes dans le temps de chargement de la page.

- 40% de vos clients quitteront le site Web si la page met plus de 3 secondes à se charger.

Pourquoi la vitesse de chargement d’un site Web est-elle importante?

Les recherches de Google montrent que le temps de chargement de la page de 1 s à 5 s augmente la probabilité de rebond de 107 %. Voyons ce qui affecte le taux de chargement du site et pourquoi vous devriez réduire le temps de réponse du serveur (TTFB). Mais au début, vous devez vérifier la vitesse de la page.

- Obtenez plus de clients: le taux est également essentiel pour charger le site à partir d’un appareil mobile. La majorité des utilisateurs d’aujourd’hui visitent des sites Web exactement à partir de smartphones, et vous devez veiller à toucher cette audience de clients potentiels.

- Améliorez l’expérience de l’utilisateur: un code de page complexe entraînera un chargement plus lent. Oubliez les sites volumineux et continuez à optimiser le code de votre site. Croyez-le, vous pourrez ainsi accélérer considérablement les performances de votre site.

- Fidéliser les utilisateurs: il ne suffit pas d’attirer l’attention du client, car il doit encore être conservé. Notez que si les pages de votre site sont chargées rapidement, les chances que l’utilisateur quitte la ressource sont parfois réduites. Remarquez que vous n’aimez pas non plus les sites lents!

- Obtenez plus de conversions: plus vos ressources se chargent rapidement, plus vous pouvez obtenir de conversions de la part d’acheteurs qui n’ont pas quitté votre site après avoir consulté la première page.

- Importance pour le SEO. La vitesse des pages affecte vraiment le SEO. C’est un facteur de classement. Mais ce n’est pas le facteur le plus important et n’affecte le classement du site qu’en combinaison avec d’autres facteurs. Découvrez le rapport vidéo de recherche sur l’impact SEO de Page Speed réalisé par Brian Dean – Backlinko.

Vous vous demandez comment vérifier gratuitement la vitesse de votre site Web?

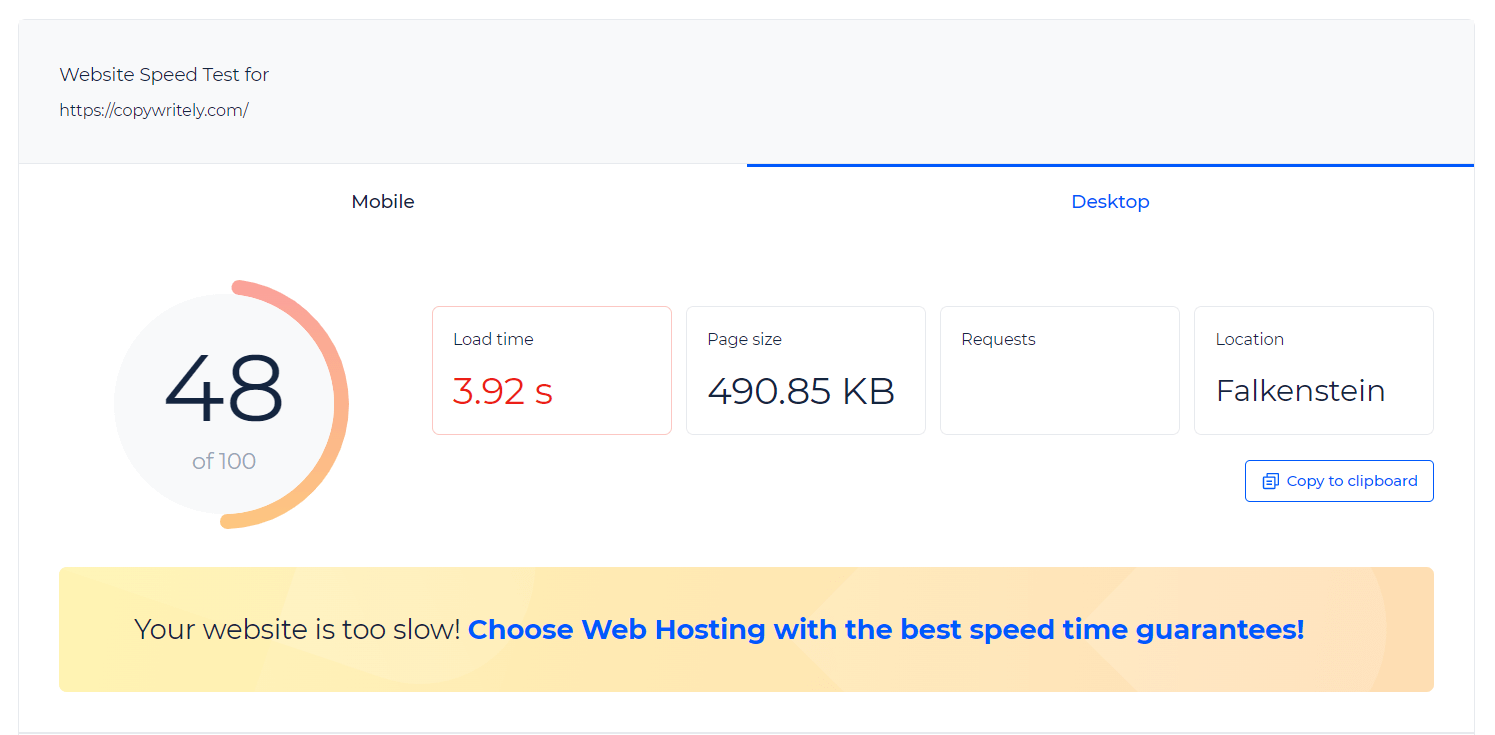

Obtenez des informations détaillées sur le taux de chargement et la taille de la page avec un test de vitesse de page. Avec nous, vous pouvez exporter les résultats dans un fichier PDF, partager un lien vers les données ou copier les informations dans le presse-papiers.

Le test de vitesse de page Web est un moyen très pratique d’obtenir les résultats des tests et de les comparer avec les indicateurs après avoir corrigé les bogues sur votre site.

Nous vous proposons un hébergement web avec les meilleures garanties de vitesse du site. Testez la vitesse de chargement du site Web avec nous ! Profitez de l’option d’exportation et analysez la vitesse de chargement de votre site grâce à notre vérificateur de vitesse de site.

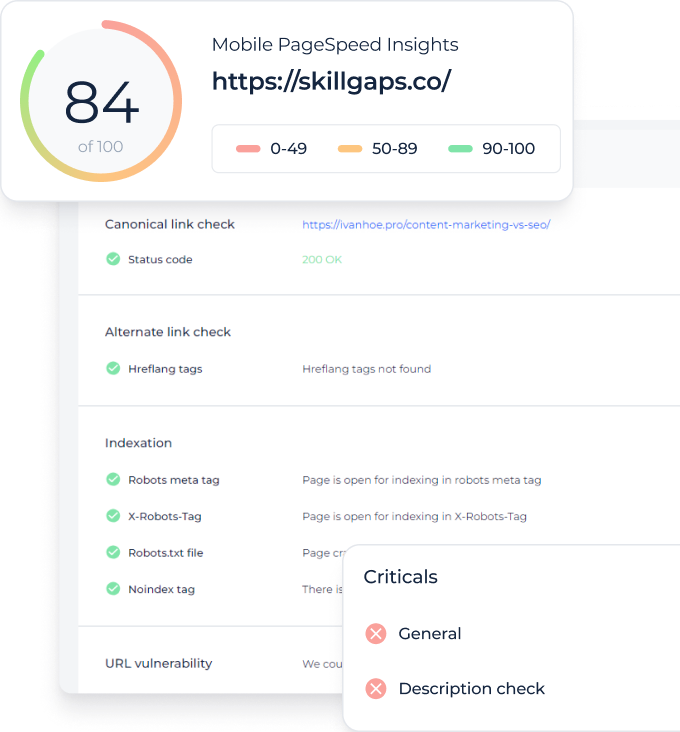

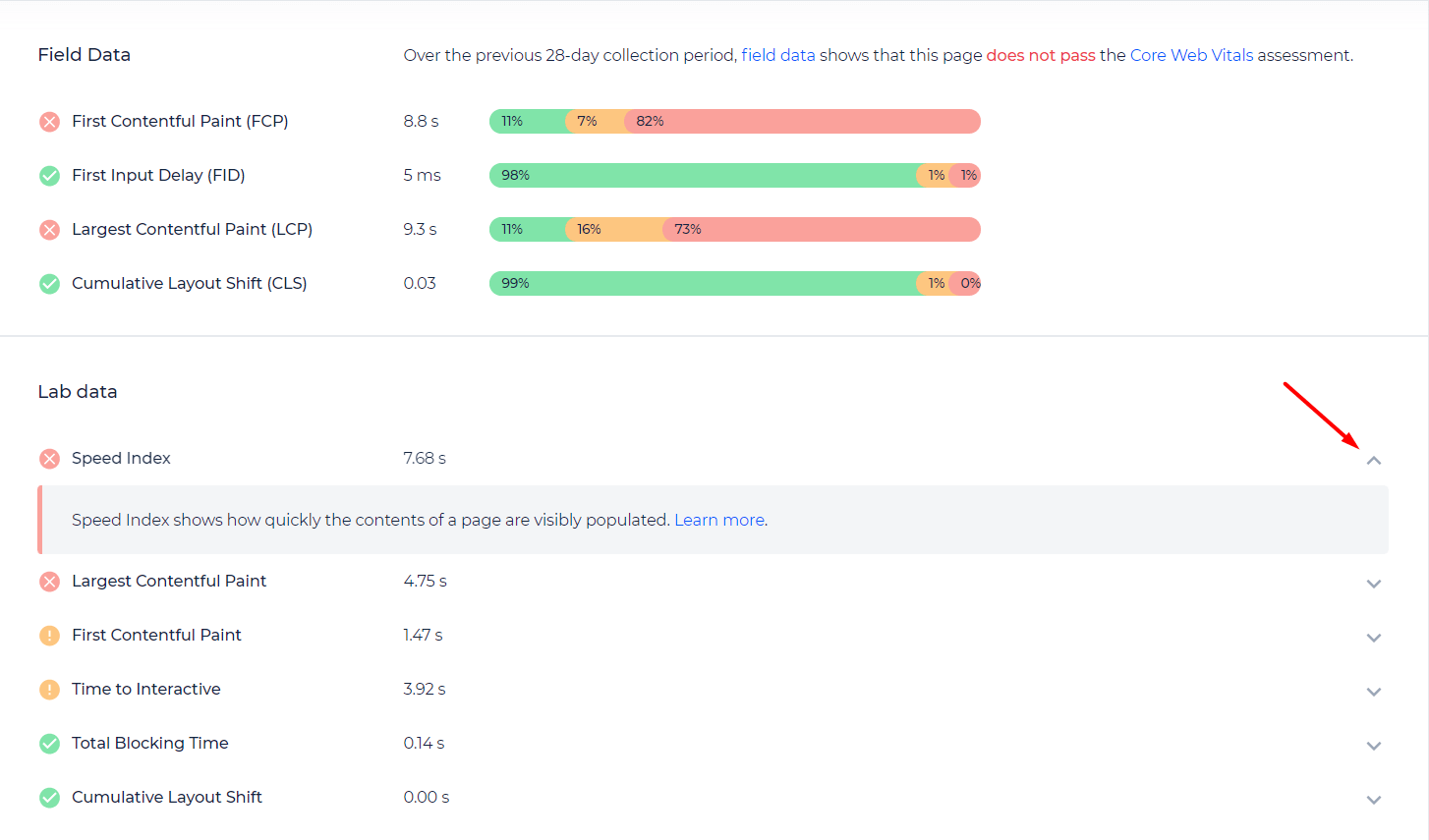

Pour votre plus grand confort, le test de site Web attribuera une note au site en fonction des recommandations de Google. L’outil vous fournit des conseils utiles sur la façon dont vous pouvez accélérer les pages de votre site et sur les erreurs que vous devez commettre pour le faire. Testez la vitesse de la page et corrigez toutes les erreurs.

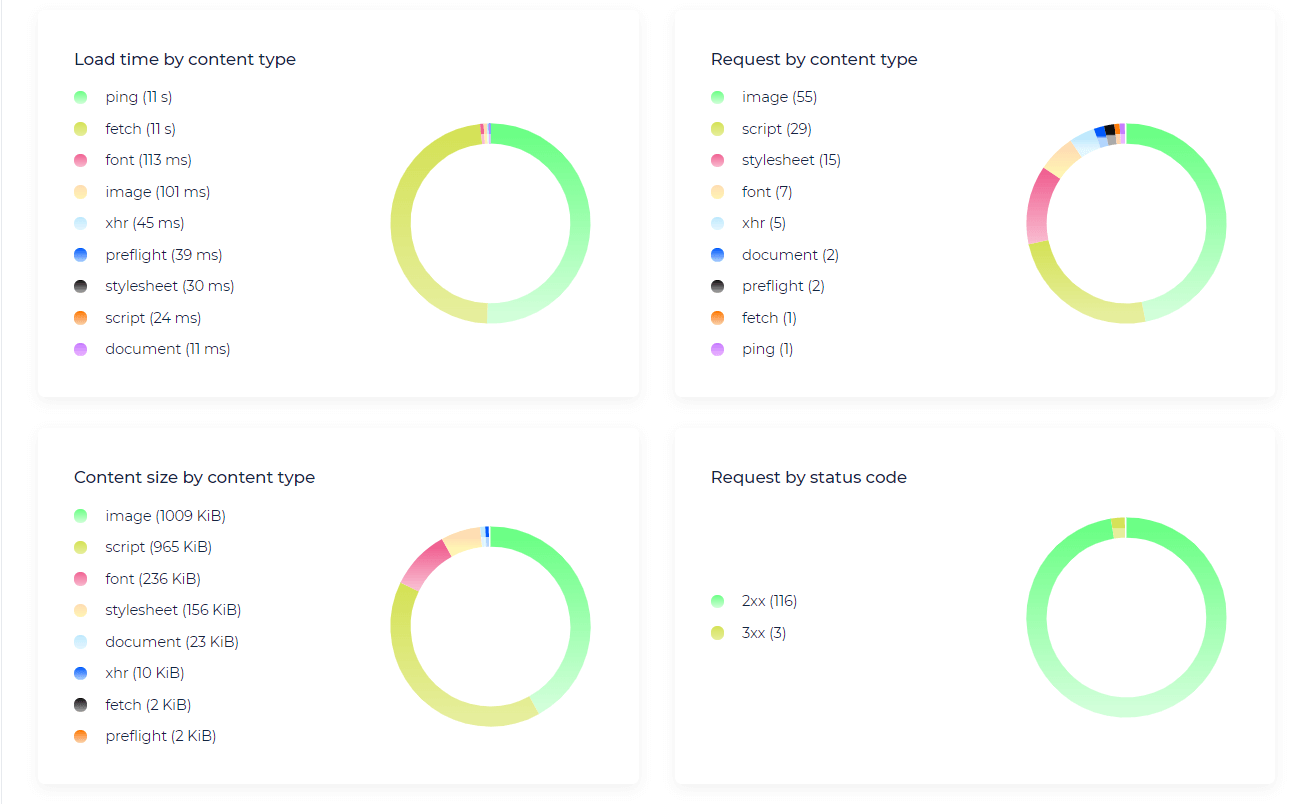

Avec des graphiques détaillés sur l’état de votre site, vous pouvez rapidement en savoir plus sur les problèmes et les aspects qui nécessitent une intervention urgente. L’outil vous montrera à quoi faire attention et comment corriger les erreurs.

Vérifiez la vitesse du site Web et accélérez avec notre test de vitesse du site!

Conseils de dépannage pour l’optimisation de la vitesse du site Web

Le test de vitesse de chargement du site Web peut améliorer le taux de votre site Web. Voici quelques-uns des problèmes les plus courants qui empêchent les sites de se charger plus rapidement et entraînent la perte de clients potentiels. Nous avons rassemblé ces conseils afin que vous sachiez par où commencer pour améliorer les performances de vos ressources. Ce sont des conseils simples que même les débutants peuvent appliquer. Faites attention aux conseils de dépannage et augmentez votre site sans trop d’effort.

Comparer la vitesse des pages de Chrome, Firefox et IE

Le vérificateur de vitesse de site Web teste le taux de chargement de votre site à partir des navigateurs les plus populaires. Il convient de rappeler que bien que la plupart des utilisateurs naviguent avec Chrome, de nombreux clients potentiels en utilisent également d’autres. Il convient donc d’accorder une attention particulière à l’optimisation pour d’autres navigateurs moins populaires afin de ne pas perdre un public et des clients potentiels.

Vérifiez la vitesse de votre site Web depuis différentes villes du monde

Obtenez une occasion unique de vérifier le taux de chargement de votre site à partir de différents endroits dans le monde. Notre outil vous donne plusieurs pays pour vérifier la vitesse de chargement de votre site pour les utilisateurs qui y vivent. Cela vous permettra d’identifier et de prévenir d’éventuels problèmes qui ralentissent votre site Web.

Testez la vitesse de votre site Web mobile

Gardez à l’esprit que la plupart des utilisateurs verront votre ressource à partir d’appareils mobiles. C’est pourquoi notre outil offre la possibilité de tester le taux de la plate-forme à partir de différents appareils. Utilisez des formats de page à chargement rapide pour que les utilisateurs obtiennent les informations de vos pages encore plus rapidement.

Optimisation du serveur

Tout d’abord, la partie serveur est facile à surveiller et à contrôler. Deuxièmement, avec de graves problèmes de temps de réponse du serveur, le ralentissement est perceptible pour tout le monde. Vous devez sérieusement prendre soin de ce paramètre afin que votre ressource soit encore mieux classée dans les résultats de recherche.

Optimisation client

Voici quelques conseils universels pour aider à accélérer n’importe quelle ressource. Tout d’abord, faites attention à ces facteurs.

| Conseils | Explication |

|---|---|

| Optimisation des polices Web | il vaut la peine de réduire la taille du trafic des polices sur votre site. Pour ce faire, utilisez WOFF2 pour les navigateurs modernes. N’utilisez que des formats populaires, latin et cyrillique. Le préchargement vous permettra d’avertir votre navigateur quand télécharger un fichier de police. La fonction d’affichage des polices offre un moyen flexible de contrôler le comportement du navigateur si le fichier est retardé ; |

| Optimisation des images | le chargement d’images lourdes ralentit considérablement le site. Vous pouvez utiliser des programmes spéciaux qui réduiront la taille de l’image. De plus, de tels services entraîneront une compression sans perte de qualité, et donc vos utilisateurs ne remarqueront même pas la différence. Utilisez ces services d’optimisation pour que les pages de votre site se chargent le plus rapidement possible en réduisant la taille des images sur les pages de votre site; |

| Compression des données | comme nous l’avons mentionné précédemment, le code de votre page Web doit être aussi simple et optimisé que possible. Supprimez les constructions encombrantes, remplacez-les par des versions plus simples. N’oubliez pas que la compression des données de votre site accélérera la ressource et ne fera pas perdre de clients potentiels. Utilisez la compression statique pour que le serveur fournisse aux utilisateurs la dernière version compressée de votre site |

Utiliser CDN

L’application de CDN est une mesure annoncée pour accélérer votre ressource. Ne négligez pas cette opportunité d’améliorer les performances de votre plateforme dès maintenant !

L’utilisateur se connecte généralement au serveur réseau le plus proche. C’est pourquoi la création de connexion TCP et TLS se produit plus rapidement. Dans le cas de données situées sur le CDN, l’utilisateur peut les obtenir beaucoup plus rapidement. Ce paramètre réduit considérablement la charge sur votre serveur.

CDN peut fournir les données de la ressource dans sa forme originale et les optimiser. Il permet d’accélérer le chargement de votre site sans trop d’effort.

Trouvez les problèmes techniques qui peuvent nuire à la vitesse de votre site !

Explorez votre site Web et découvrez toutes sortes de problèmes qui peuvent nuire à la vitesse de votre site Web et à votre référencement en général.